Персептроны. Назначение, обобщенная схема, виды персептронов, принципы работы. Достоинства и недостатки персептронных систем

Содержание:

МИНИСТЕРСТВО ОБРАЗОВАНИЯ И НАУКИ РОССИЙСКОЙ ФЕДЕРАЦИИ

МОСКОВСКИЙ ФИНАНСОВО-ПРОМЫШЛЕННЫЙУНИВЕРСИТЕТ «УНИВЕРСИТЕТ»

Введение

С текущим уровнем развития ускорение прогресса возможно благодаря тому, что компьютерные технологии способны принимать на себя часть работы. Искусственный интеллект является одним из способов обеспечения поддержкой в решении сложных задач, позволяющий рассчитывать не только на решение однотипных операций, но и способный обучаться. Одна из ветвей развития искусственного интеллекта - нейронные сети –позволяет создавать прогнозы, распознавать образы, оптимизировать, участвовать в управлении, чем приносит существенную помощь в поиске и нахождении решений. Искусственные нейронные сети смоделированы по принципу биологических нейронных систем – это система соединенных между собой простых процессоров (нейронов), они отличаются простотой, но способны решать сложные задачи, будучи объединенными в сеть, в которой они смогут взаимодействовать. Весь принцип их действия сводиться к получению информации, обработке и выдаче информации. Главное преимущество нейронных сетей в том, что они способны обучаться, или другим языком, способны находить зависимости между входными и выходными данными. После обучения сеть может предсказывать будущие значения на основе предыдущих значений. Однако только в том случае, когда предыдущие значения действительно могли предсказать некоторую закономерность будущих результатов.

Целью данной работы является рассмотрение персептронов, их принципов работы и применения.

Объектом работы являются персептроны.

Предметом работы являются принципы работы персептронов.

Работа является актуальной по той причине, что персептроны широко используются в различных областях науки.

Для достижения поставленной цели необходимо решить следующие задачи:

- Дать понятие персептрона;

- Рассмотреть виды персептронов;

- Рассмотреть алгоритмы их обучения;

- Описать принципы их работы;

- Дать основные достоинства и недостатки персептронов.

1. Общие сведения о персептронах

1.1.Понятие персептрона

Персептрон – этосеть, основанная на передаче информации, и состоящая из трех типов, генерирующих сигналы: реагирующих элементов, элементов ассоциативных и сенсорных. Существует зависимость производящих функций данных элементов, которые возникают в передающей сети, или же, для внешних элементов, получаемых из внешней среды. Сигналы, которые оказывают воздействие на производящую функцию элемента, называются входными сигналами для этого элемента. Эти элементы определены в достаточно общем виде и как частный случай включают в себя биологические нейроны.

Персептрон является компьютерной или математической моделью восприятия информации человеческим мозгом, предложенной Фрэнком Розенблаттом впервые в 1957 году, и воплощенной в виде электронной машины «Марк-1»уже в 1960 году. Таким образом, персептрон считается первой моделью нейронных сетей, а «Марк-1»занимает место первого в мире нейрокомпьютера. [1]

Три типа элементов составляют персептрон: датчики принимают поступающие сигналы, затем датчики передают полученные сигналы в сектор ассоциативных элементов, и после этого на реагирующие элементы. Таким образом, персептроны дают возможность создать некоторый набор «ассоциаций» между начальными стимулами и требуемой выходной реакцией. С точки зрения биологии это несколько сравнимо с преобразованием, к примеру, поступающих зрительных сигналов в физиологическую реакцию, создаваемую двигательными нейронами.Современная терминология относит персептроны к искусственным нейронным сетям, персептроны могут быть с:

- Сигналом с принципом прямого распространения;

- Передаточной пороговой функцией;

- Одним скрытым слоем.

По причине повышения популярности нейросетей, Марвин Минский и Сеймур Паперт выпустили в 1969 году книгу, принципиально описывающую ограниченность персептронов, что имело свои последствия, исследование искусственного интеллекта учеными перешло в обратную от нейронных сетей сферу символьных вычислений. Помимо этого, сложность математического исследования персептронов вместе с отсутствующей общепринятой терминологией, привели к возникновению неточностей и заблуждений.[10]

В будущем возобновился интерес в нейронным сетям и к работам Розенблатта. К примеру, сейчас можно наблюдать стремительное развитие биокомпьютинга, вычисления которого в теоретической основе берут свое начало из нейронных сетей.

1.2.Общие сведения о персептронах

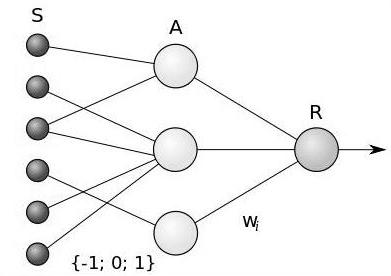

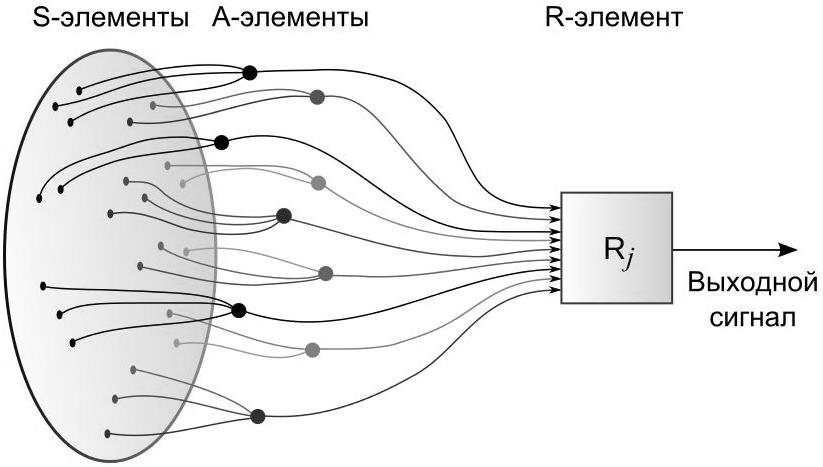

На рис.1.1. показана логическая схема элементарного персептрона, который состоит из элементов, разделенных на три типа: S-элементов, наиболее многочисленных, A-элементов, средней численности, и одного R-элемента. S-элементы — это слой сенсоров, принимающих сигналы, или же рецепторов. Что в физическом мире соответствует светочувствительным элементам на сетчатке глаза или фоторезисторам камеры. Для каждого из рецепторов характерно нахождение либо в состоянии покоя, либо в состоянии возбуждения. Только в состоянии возбуждения рецептор передаст единичный сигнал следующему слою ассоциативных элементов.

Рис. 1.1. Элементарный персептрон. Логическая схема.

A-элементы названы ассоциативными, так как каждому данному элементу, зачастую соответствует целый набор S-элементов. A-элемент приходит в состояние активности, когдасигналы от S-элементов на входе количеством превышают определенную величину θ. Следовательно, если набор необходимых S-элементов находиться на сенсорном поле в форме буквы «Д», то A-элемент переходит в состояние активности.При условии, чтонужное количество рецепторов передало информацию о появлении «пятна света» в наблюдаемой ими окрестности, то есть A-элемент будет ассоциирован с наличием или отсутствием буквы «Д» в определенной области. Наглядно это продемонстрированно на рисунке 1.2. [8]

Рис. 1.2. Физическое воплощение поступающего сигнала

Сигналы от возбужденных A-элементов передаются на сумматор R, а сигнал от i-го ассоциативного элемента передается с коэффициентом wi. Этот коэффициент называется весом связи A-R.

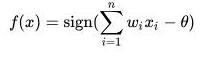

R-элемент, так же, как A-элементы, подсчитывает сумму значений входных сигналов, умноженную на веса. R-элемент, а вместе с ним и элементарный персептрон, выдает "1", Если линейная форма превышает порог θ, иначе на выходе будет"-1". Математически функция, реализуемая R-элементом, может быть записана как:

(1.1)

(1.1)

Обучение элементарного персептрона состоит в изменении весовых коэффициентовwi связей A-R. Веса связей S-A (которые могут принимать значения {-1; 0; +1}), и значения порогов A-элементов выбираются случайным образом в самом начале и остаются неизменными.

Готовность к режиму распознавания или обобщения становиться доступной для персептрона по окончании этапа обучения. Этот режим предъявляет персептрону неизвестные ему ранее объекты, и задача персептрона установить к какому классу они могут принадлежать. Работа персептрона состоит в следующем: при предъявлении объекта возбудившиеся A-элементы передают сигнал R-элементу, равный сумме соответствующих коэффициентов wi. Принадлежность к первому классу будет являться результатом решения, которое опирается на положительность суммы, а если сумма отрицательна – объект будет принадлежать второму классу. [4]

1.3. Виды персептронов

Для более глубокого знакомства с теорией персептронов необходимо знание элементарных определений и теорем, которые представляют собой основу для последующих видов нейронных сетей. Для минимального уровня требуется понимание с позиции теории сигналов, которая является оригинальной, то есть описанной автором персептронов Ф. Розенблаттом.

Для начала необходимо дать определение составным элементам персептрона, являющимся частными случаями искусственных нейронов с пороговой передаточной функцией:

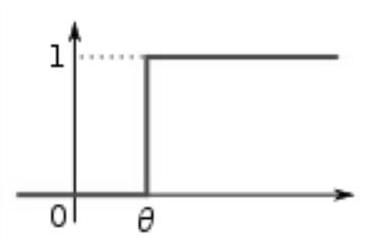

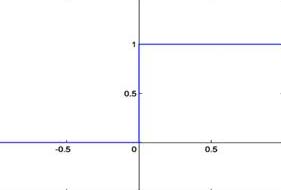

- Простым сенсорным S-элементом называется чувствительный элемент (рис. 1.3), воздействие на который каким либо видом ( свет, звук, давление, тепло и т. п.) создает сигнал. Если входным сигналом превышен некоторый порог θ, на выходе элемента получается +1, в обратном случае - 0.

- Простым ассоциативнымA-элементом является логический решающий элемент (рис. 1.3), дающий выходной сигнал +1, при превышении входных сигналов алгебраической суммы некоторую пороговую величину θ (тогда элемент активный), иначе выход определяется как равный нулю.

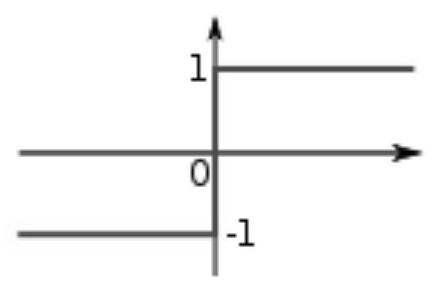

- Простым реагирующим (действующим) R-элементом называется элемент (рис. 1.4), выдающий сигнал +1, когда сумма его входных сигналов является только положительной, и сигнал -1, если сумма его входных сигналов является только отрицательной. Когда сумма входных сигналов равна нулю, выход считается или равным нулю, или неопределённым. [5]

Рис. 1.3. Пороговая функция, реализуемая S- и A-элементами

Рис. 1.4. Пороговая функция, реализуемая R-элементом

Если на выходе любого элемента результатом является 1, то элемент возбужден или активен.

Рассмотренные элементы называются простыми, поскольку они реализуют скачкообразные функции. По утверждению Розенблатта, решение более сложных задач потребует другие функции, такие, к примеру, как линейная.

Как итог, Розенблаттом введены следующие определения:

- Персептрон - это сеть, составляют которую S, A и R-элементы, с переменной матрицей взаимодействия W (элементами которой являются {\displaystyle w_{ij}}весовые коэффициенты), в определении которой играют роль прошлые состояния активности сети.

- Персептрон с последовательными связями - это система, все связи которой начинаются от элементов с логическим расстоянием d от ближайшего S-элемента и оканчиваются на элементах с логическим расстоянием d+1 от ближайшего S-элемента.

- Простым персептроном является система, удовлетворяющая нижеприведенным условиям:

- В системе имеется только один R-элемент (он связан всеми A-элементами);

- Система представляет собой персептрон с последовательными связями, идущими только от S-элементов к A-элементам и от A-элементов к R-элементам;

- Веса всех связей от S-элементов к A-элементам (S-A связей) неизменны;

- Время передачи каждой связи равно либо нулю, либо фиксированной постоянной {\displaystyle \tau }

;

;

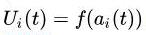

Все активирующие функции S, A, R-элементов имеют вид: (1.2)

(1.2)

{\displaystyle U_{i}(t)=f(a_{i}(t))}где {\displaystyle a_{i}(t)}ai(t) — алгебраическая сумма всех сигналов, поступающих одновременно на вход элементаui;

- Элементарным персептроном называется простой персептрон, у которого все элементы - простые. В этом случае его активизирующая функция имеет вид: [6]

(1.3)

(1.3)

В дополнение можно обратить внимание на концепции, которые Розенблатт предложил в книге, и которые позднее были развиты в рамках теории нейросетей:

- Персептрон с перекрёстными связями - это система, в которой элементы одного типа имеют связи, которые находятся на одинаковом расстоянии от S-элементов, при этом все остальные связи являются связями последовательного типа.

- Персептрон с обратной связью – система может быть названа данным образом, когда достаточно одной связи между логически более удаленным элементом и логически менее удаленным. Современная терминология называет эти сети рекуррентными.

- Персептрон с переменными S-A связями - это система, в которойснимаются ограничения на фиксированные связи от S-элементов к A-элементам. Характеристики персептрона значительно улучшаются при оптимизации S—A связей.

Марвин Минский занимался изучением свойств параллельных вычислений, и персептрон на то время являлся их частным случаем. Он перевел теорию персептронов, для анализа свойств персептрона, на язык предикатов. Суть его подхода заключалась в следующем:

- Переменная X была сопоставлена множеству сигналов от S-элементов;

- предикат φ(X)был сопоставлен каждому A-элементу, и был назван частным предикатом;

- предикат ψ (пси)был сопоставлен каждому R-элементу, и зависел от частных предикатов;

- персептрон был определен как устройство, которое способно вычислить все предикаты типа ψ.

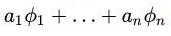

В «зрительном» персептроне, переменная X была образом какой-нибудь геометрической фигуры (стимулом). Частный предикат давал возможность «распознавать» каждому свою фигуру. Предикат ψ означал ситуацию, в которой линейная комбинация

(1.4){\displaystyle a_{1}\phi _{1}+\ldots +a_{n}\phi _{n}}

(1.4){\displaystyle a_{1}\phi _{1}+\ldots +a_{n}\phi _{n}}

где ai– это {\displaystyle a_{i}}коэффициенты передачи, превышала некоторый порог θ. [3]

Существует 5 семейств персептронов, которые обладают интересными свойствами:

1. Персептроны, которые ограниченны по диаметру - каждая фигура X, распознанная частными предикатами, по диаметруне превосходит некоторую фиксированную величину.

2. Персептроны ограниченного порядка - каждый частный предикат зависит от ограниченного количества точек из X.

3. Персептроны Гамбы - каждый частный предикат (мини-персептрон) должен являться линейной пороговой функцией.

4. Случайные персептроны –это персептроны ограниченного порядка, в которых частные предикаты являются случайно выбранными булевыми функции. Подробно группой Розенблатта изучалась именно эта модель.

5. Ограниченные персептроны - множество частных предикатов является бесконечным, а множество возможных значений коэффициентов -конечным.

Этот математический аппарат допустил возможность применения анализа только к элементарному персептрону, но было вскрыто множество ограничений для параллельных вычислений. Все виды современных искусственных нейросетей подчинены этим ограничениям.

Такое понятие, как «персептрон» имеет интересную историю. Первоначальный смысл понятия был искажен из-за неразвитой терминологии нейросетей в прошлом, непонимания задач, резкой критики исследований персептронов, и ложного описания прессой. Сравнение разработок Розенблатта и современных образов и статей дает возможность выделения четырех обособленных классов персептронов:

- Персептрон с одним скрытым слоем – является классическим персептроном, наиболее тщательно рассматриваемым в большей части книги Розенблатта. Имеет по одному слою S-, A- и R-элементов.

- Однослойный персептрон – модель, где при помощи системы весов возможно прямое соединение входных элементов с выходными. Является частным случаем классического персептрона и простейшей сетью прямого распространения — линейным классификатором, в котором каждый S-элемент однозначно соответствует одному A-элементу, S-A связи имеют вес +1 и все A-элементы имеют порог θ = 1. Однослойные персептроны - это фактическиформальными нейронами, то есть пороговыми элементами Мак-Каллока - Питтса. Они имеют множество ограничений, например, они не способны идентифицировать ситуацию, если их входы получили разные сигналы.

- Многослойный персептрон (по Розенблатту) - персептрон, имеющий дополнительные слои A-элементов.

- Многослойный персептрон (по Румельхарту) - персептрон, имеющий дополнительные слои A-элементов, но эта сеть обучается при помощи обратного распространения ошибки, и обучаются все слои (в том числе S и A). Является частным случаем многослойного персептронаРозенблатта(рис. 1.5).

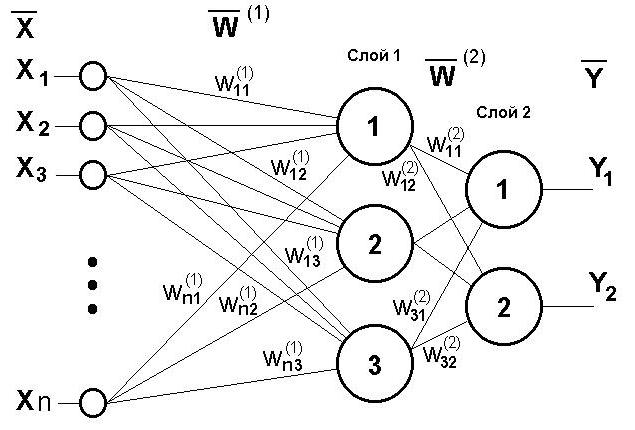

Рис. 1.5. Архитектура многослойного персептрона

В настоящее время в литературе более известен однослойный персептрон, именно его подразумевают под термином «персептрон», но имеет место быть часто встречающееся заблуждение, что этот тип моделей был предложен Розенблаттом. В противоположность однослойному воспринимают «многослойный персептрон»,зачастую имея ввиду многослойный персептронРумельхарта, а не Розенблатта. Классический же персептрон относят к многослойным.[9]

Однослойный персептрон

Однослойный персептрон представляет собой простейшую модель нейронной сети. Однослойный персептрон получает на вход сигнал, заданный вектором  и на выходе выдает число

и на выходе выдает число

,(1.5)

,(1.5)

где

.(1.6)

.(1.6)

Входной вектор  состоит из n компонент

состоит из n компонент

, (1.7)

, (1.7)

каждая из которых представляет собой численную характеристику анализируемого нейронной сетью объекта.

Через  и

и  обозначены параметры персептрона — синаптические веса и порог (сдвиг).Синаптические веса указывают силу влияния конкретной характеристики на выходное значение. Их значения могут быть как положительными, так и отрицательными.

обозначены параметры персептрона — синаптические веса и порог (сдвиг).Синаптические веса указывают силу влияния конкретной характеристики на выходное значение. Их значения могут быть как положительными, так и отрицательными.

Отметим, что переменные  могут быть булевскими, то есть принимать значения 0 или 1. Это означает, что объект обладает данным признаком, если

могут быть булевскими, то есть принимать значения 0 или 1. Это означает, что объект обладает данным признаком, если  , и не обладает, в случае, если

, и не обладает, в случае, если  . В этом случае функция

. В этом случае функция

(1.8)

(1.8)

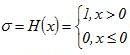

— функция Хевисайда или функция скачка.

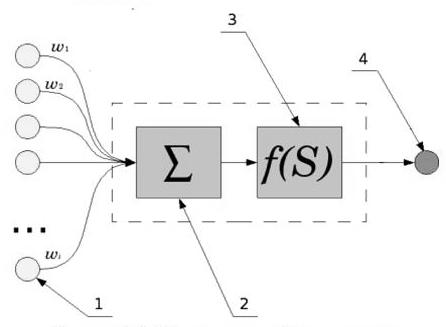

Рисунок 1.6. Модель однослойного персептрона

На рис. 1.6 приведена модель однослойного персептрона, цифрами 1-4 помечена последовательность действий при работе алгоритма.

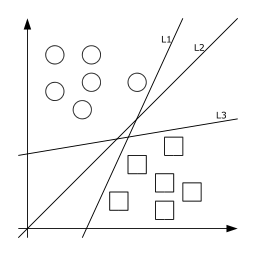

Преимущество персептрона заключается в его простоте. Укажем и его недостаток — персептрон классифицирует только линейно разделимые объекты (то есть только такие множества векторов, между которыми можно провести разделяющую эти множества гиперплоскость).Геометрическая интерпретация

Однослойный персептрон работает как классификатор объектов двух разных множеств. Чтобы понять, как это происходит, рассмотрим случай, когда сигмоидальная функция есть функция скачка  . Предположим, требуется классифицировать объекты в два непересекающихся класса объектов A и B. Для этого, определим выходные значения: положим

. Предположим, требуется классифицировать объекты в два непересекающихся класса объектов A и B. Для этого, определим выходные значения: положим  , если объект принадлежит к классу A,

, если объект принадлежит к классу A,  , если объект принадлежит к классу B:

, если объект принадлежит к классу B:

, (1.9)

, (1.9)

Тогда, из определения функции скачка  следует, что объект лежит в классе A при условии

следует, что объект лежит в классе A при условии  и объект лежит в классе B, если

и объект лежит в классе B, если  .

.

Следовательно, уравнение  может быть рассмотрено как некий разделитель множеств объектов разных классов.

может быть рассмотрено как некий разделитель множеств объектов разных классов.

С другой стороны, уравнение  равносильно уравнению

равносильно уравнению

,(1.10)

,(1.10)

которое определяет гиперплоскость в n-мерном линейном пространстве.

Напомним, что в двумерном пространстве гиперплоскость — это прямая, а в трехмерном — обычная плоскость.

Следующая иллюстрация (рис. 1.7) демонстрирует вышесказанное на примере игры в квадратики (класс A) и шарики (класс B) в случае n=2, то есть на плоскости. Прямые  ,

, ,

,  — примеры «разделителей» этих классов.

— примеры «разделителей» этих классов.

Рисунок 1.7. Геометрическая интерпретация однослойного персептрона

Таким образом, однослойный персептрон есть линейный разделитель.

Многослойный персептрон

Пусть известен реальный выход устройства  при входе

при входе  , где

, где  — вектор с компонентами

— вектор с компонентами  , t — номер проводимого опыта,

, t — номер проводимого опыта,  (максимальное число опытов T заранее определено).

(максимальное число опытов T заранее определено).

Необходимо найти параметры модели

(1.11)

(1.11)

, (1.12)

, (1.12)

,

,  такие, что выход модели

такие, что выход модели  и реальный выход устройства

и реальный выход устройства  были бы как можно ближе. Эта задача всегда разрешима так называемыми многослойными персептронами. Эту модель мы рассматриваем ниже.

были бы как можно ближе. Эта задача всегда разрешима так называемыми многослойными персептронами. Эту модель мы рассматриваем ниже.

Связь между входом и выходом двухслойного персептрона устанавливают следующие соотношения:

,(1.13)

,(1.13)

.(1.14)

.(1.14)

К явным преимуществам многослойного персептрона следует отнести возможность с его помощью классифицировать любые объекты, разделимые в пространстве признаков. Этот результат был получен лишь в 90-e годы XX века.

К недостаткам относят сложность и медленность настройки, а также плохая способность к обобщению. Чтобы преодолеть эту трудность, применяются эвристические приемы и методы.

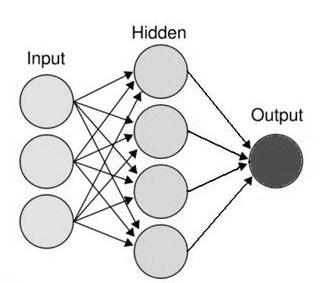

Рисунок 1.8. Модель многослойного персептрона с одним скрытым слоем (N=1)

Рисунок 1.8 иллюстрирует архитектуру двухслойного персептрона, где число скрытых слоев N=1. Трехслойный персептрон, очевидно, имеет два скрытых слоя (то есть два ряда «голубых» шариков), и т.д. Необходимо отметить, что в каждом скрытом слое может быть разное число нейронов. [8]

Архитектура многослойного персептрона

Многослойный персептрон способен на абсолютное разделение, то есть может провести любую разделяющую гиперповерхность. Сформулируем это утверждение неформальным образом в следующей теореме:

Фундаментальная теорема

Пусть имеется два произвольных непересекающихся множества в многомерном линейном пространстве. Тогда с помощью многослойного персептрона всегда можно разделить эти два множества, то есть провести гиперповерхность, разделяющую их.

В формальных терминах приведенная теорема об универсальной аппроксимации может быть изложена так:

Фундаментальная теорема о разделимости классов

Для любой непрерывной функции

, (1.15)

, (1.15)

определенной на ограниченной замкнутой области, и каждого  существуют коэффициенты

существуют коэффициенты

и

и  ,

, ,

,  , (1.16)

, (1.16)

такие, что

.(1.17)

.(1.17)

Заметим, что выражение

(1.18)

(1.18)

описывает персептрон с одним скрытым слоем. Таким образом, теорема утверждает, что одного скрытого слоя достаточно, чтобы аппроксимировать все (то есть любую непрерывную функцию, определенную на ограниченном множестве).

Основные идеи доказательства.

Доказательство теоремы проводится сначала для одномерного входа ( ), в этом случае вектор входов представляет собой скаляр:

), в этом случае вектор входов представляет собой скаляр:  . Это может быть сделано разложением по всплескам методом Фурье (пункт A). Затем рассматривается случай произвольной размерности вектора входов (пункт B); при этом применяется разложение функции с помощью Фурье по плоским волнам, что сводит задачу к пункту A.

. Это может быть сделано разложением по всплескам методом Фурье (пункт A). Затем рассматривается случай произвольной размерности вектора входов (пункт B); при этом применяется разложение функции с помощью Фурье по плоским волнам, что сводит задачу к пункту A.

Пункт A.  ,

, . Дляскалярного

. Дляскалярного  имеем

имеем

(1.19)

(1.19)

|f(x) - Σm=1,…Mam σ (wmx - hm)|<ε (1.20)

Мы приближаем производную

(1.21)

(1.21)

|f’(x) - Σm=1,…Mamσ’ (bm (x - hm ))|<ε (1.22)

Введем всплеск

(1.23)

(1.23)

тогда последнее неравенство, как следует из теории вейвлетов (она будет изложена ниже), может быть записано как

(1.24)

(1.24)

f’(x) - Σm=1,… к сmψ (bm (x - hm ))|<ε

Пункт B.

,

,  ,

,  . (1.25)

. (1.25)

Из теории рядов Фурье следует, что любую функцию многих переменных

(1.26)

(1.26)

можно представить в виде суммы функций одного переменного, то есть

,(1.27)

,(1.27)

Где

. (1.28)

. (1.28)

Заметим, что увеличение числа нейронов может подавить шум с сохранением той же точности аппроксимации:

. (1.29)

. (1.29)

σ(bm (x - hm )) =0.5 [σ(bm (x - hm )) + σ(bm (x - hm )) ] (1.30)

Обучение многослойного персептрона происходит по алгоритму градиентного спуска, аналогичному однослойному. Один из знаменитых вариантов этого алгоритма получил название метод обратного распространения ошибки.

1.4. Алгоритмы обучения

Способность к обучению является важным свойством нейронной сети любого вида. Процесс обучения – это важная процедура для настройки весов и порогов, целью которой служит уменьшение разности между целевыми и получаемыми векторами на выходе. Розенблатт принимал попытки к классификации алгоритмов обучений персептрона, называя их системами подкрепления, что означает любой набор правил, основывая на которые матрицу взаимодействия персептрона (состояние памяти) можно изменять с течением времени. [7]

При описании этих системподкрепления и уточнения возможных их видов, Розенблатт брал за основу идеи Д. Хебба, предложенных в 1949 году, из которых можно вывести правило, состоящее из этих частей:

- Если два нейрона по обе стороны синапса (соединения) активизируются одновременно (то есть синхронно), то прочность этого соединения возрастает.

- Если два нейрона по обе стороны синапса активизируются асинхронно, то такой синапс ослабляется или вообще отмирает

Метод коррекции ошибки является классическим методом обучения персептрона и представляет собой вид обучения с учителем, в котором все связи остаются неизменными, пока персептрон дает правильную реакцию. Появление неправильной реакции приведет к изменению веса на единицу, а знак (+/-) определится противоположным от знака ошибки.

Допустим, нужно обучить персептрон как разделять два класса объектов, чтобы в результате при предъявлении объектов первого класса, выход персептроне был положительным (+1), а при предъявлении объектов второго класса — отрицательным (−1). Для этого нужен следующий алгоритм:

- Случайным образом выбираются пороги для A-элементов и устанавливаются связи S-A.

- Начальные коэффициенты wiравны нулю.

- Предъявляется обучающая выборка: объекты с указанием класса, к которым они принадлежат.

- Персептронупоказывается объект первого класса. При этом некоторые A-элементы возбудятся. Коэффициенты wi, соответствующие этим возбуждённым элементам, увеличиваются на 1.

3.2. Предъявляется объект второго класса и коэффициентыwi тех A-элементов, которые возбудятся при этом показе, уменьшаются на 1.

- Обе части шага 3 выполняются для всей обучающей выборки. В результате обучения сформируются значения весов связейwi.

С помощью теоремы сходимости персептрона, описанной и доказанной Ф. Розенблаттом, можно увидеть, что обучение элементарного персептрона по такому алгоритму, вне зависимости от начального состояния весовых коэффициентов и последовательности появления стимулов, приведёт к достижению решения за конечный промежуток времени.

Существует так же понятие «обучение без учителя», введенное Розенблаттом.

Альфа-система подкрепления — это система подкрепления, при которой веса всех активных связей cij, которые ведут к элементу uj, изменяются на одинаковую величину r, а веса неактивных связей за это время не изменяются.

После, с созданием понятия «многослойныйперсептрон», альфа-система была модифицирована, и получила название - дельта-правило. Модификация была проведена, чтобы сделать функцию обучения дифференцируемой, что в свою очередь нужно для применения метода градиентного спуска, благодаря которому возможно обучение более одного слоя.

Для обучения многослойных сетей, ряд учёных, в том числе Д. Румельхарт, предложил градиентный алгоритм обучения с учителем, позволяющий проводить сигнал ошибки к входам персептрона, слой за слоем, но вычисленный выходами персептрона.Преимущество его заключается в способности обучать все слои сети, и его легко просчитать локально. В списке недостатков этого метода – длительность, для его применения нужно, чтобы передаточная функция нейронов была дифференцируемой. При этом в персептронах пришлось отказаться от бинарного сигнала, и пользоваться на входе непрерывными значениями. [3]

2. Принципы работы, применение

2.1 Принципы работы персептронов

Первый принцип, который используют нейронные модели это использовать аналогии с мозгом и реальными нейронами. В связи с этим формулируются основные факты о мозге и нейронах:

- Мозг состоит из нейронов

- Нейроны связаны друг с другом

- Нейроны обмениваются сигналами

- Сигналы имеют булевскую природу

- Система связанных нейронов - это стохастическая динамическая система

Упрощенно, нейрон - это пороговая система, которая получает входные сигналы от других нейронов, суммирует их и если эта сумма превышает некий порог, генерирует выходной сигнал.

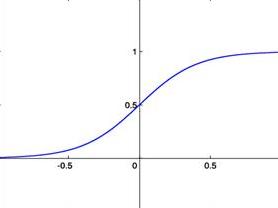

Идеализированная модель такой пороговой системы может быть построена при помощи сигмоидальных функций. Типичный график такой функции имеет следующий вид:

Рисунок 2.1. Пример сигмоидальной функции

Приведем в качестве примера несколько функций подобного рода:

(2.1)

(2.1)

где x — амплитуда входного сигнала, который получает нейрон от других нейронов; σ — выходной сигнал нейрона (рис. 2.1.);

(2.2)

(2.2)

функция скачка или функция Хевисайда (рис. 2.2);

Рисунок 2.2 Функция Хевисайда

- Кусочно-линейная (функция

)

) - Кусочно-полиномиальная

При распознавании образов в мозге происходят сложные процессы. Упрощенно систему распознавания образов можно представить как многослойный персептрон.

Сигналы из многослойного персептрона обрабатываются кортекс - это рекуррентная нейросеть.

Силу связи между нейронами описывает матрица синаптических связей W. Известно, что вся долговременная фундаментальная информация хранится в этой матрице. Матрица синаптических связей W медленно меняется со временем. Итак, в сети две динамики — быстрая динамика нейронов, описываемая динамической системой, и медленная, связанная с изменением силы связи между нейронами. Медленная динамика упрощенно описывается так называемым правилом Хебба. Хебб — канадский физиолог, который экспериментально показал, что если дванейрона оба часто одновременно активны, то сила связи между ними растет. Возможны разные варианты математической записи такого правила. [9]

Если воспользоваться простейшим вариантом правила Хебба, предложенным С. Фузи, Н. Брюнелем и др., то можно показать, что это правило в совокупности с шестислойным персептроном реализует все важнейшие алгоритмы (преобразование Фурье и т.д.).

Рассмотрим общие принципы функционирования нейронных сетей на примере задачи классификации.

Предположим, мы хотим создать автоматическую систему, которая различает два типа объектов, А и B. Системы технического зрения позволяют записать данные об объектах (признаки объекта) в цифровом виде.

Предположим, что мы характеризуем объект с помощью набора признаков  . Признаки могут быть выражены с помощью целых чисел или даже булевских переменных, то есть «есть признак» — «нет признака».

. Признаки могут быть выражены с помощью целых чисел или даже булевских переменных, то есть «есть признак» — «нет признака».

Совокупность признаков можно рассматривать как вектор с k компонентами, или точку k-мерного Эвклидова пространства

. (2.3)

. (2.3)

Тогда задача классификации сводится к следующей математической задаче: разделить два множества точек А и Bk-мерного Эвклидова пространства некоторой гиперповерхностью размерности k-1.

Сделаем некоторые важные комментарии. Выбор признаков для классификации является исключительно сложной задачей, которую мы пока не рассматриваем. Ранее это задача решалась вручную, в последнее время появились эффективные методы автоматического нахождения наиболее эффективных признаков. Отметим, что выбор правильных признаков важен для успешности последующей обработки системы признаков методами, которые мы описываем ниже.

Обучение нейронной сети в задачах классификации происходит на наборе обучающих примеров  , для которых принадлежность объекта к классу А или классу B известна. Кроме того, определим индикатор:

, для которых принадлежность объекта к классу А или классу B известна. Кроме того, определим индикатор:

.(2.4)

.(2.4)

По накопленному в результате обучения «опыту» строим сеть, которая проводит разделяющую поверхность.

Математически этот процесс может быть описан как поиск некоторой функции

(2.5)

(2.5)

где W - набор параметров нейронной сети. Эти параметры, в частности, задают силу связи между нейронами и подбираются так, чтобы ошибка обучения

(2.6)

(2.6)

где  берутся из обучающего множества, была бы минимальной (как можно ближе к нулю).

берутся из обучающего множества, была бы минимальной (как можно ближе к нулю).

Для проверки эффективности обучения нейронной сети берут тестовое множество объектов и вычисляют

(2.7)

(2.7)

где  взяты из тестового множества.

взяты из тестового множества.

После того, как система обучена (что иногда требует большого процессорного времени), она решает автоматически для любого поданного на вход системы объекта  , к какому классу он относится.

, к какому классу он относится.

2.2 Применение персептронов

Разберем практическое применение персептронов на двух различных задачах. Задача прогнозирования (эквивалент задачи распознавания образов) требует высокой точности, а задача управления агентами требует высокой скорости обучения. Однако варианты использования персептронов на этом не исчерпываются. [8]

В практических задачах от персептронанужен выбор более чем из двух вариантов, следовательно,на выходе у него должно находиться более одного R-элемента. При взаимодействииобучающегося агента со средой, важной частью являются обратные связи.

В этих задачах от персептрона требуется установить принадлежность объекта к какому-либо классу. Точность распознавания будет во многом зависеть от представления выходных реакций персептрона. В этой случае возможны три типа кодирования: конфигурационное, позиционное, и гибридное. Позиционное кодирование, когда каждому классу соответствует свой R-элемент, даёт более точные результаты, чем другие виды. Однако оно неприменимо, когда число классов, например, несколько сотен.

В искусственном интеллекте часто рассматриваются обучающиеся (адаптирующиеся к окружающей среде) агенты. При этом в условиях неопределённости становится важным анализировать не только текущую информацию, но и общий контекст ситуации, в которую попал агент, поэтому здесь применяются персептроны с обратной связью. Кроме того, в некоторых задачах становится важным повышение скорости обучения персептрона. [2]

2.3. Достоинства и недостатки

Розенблатт предложил ряд психологических тестов для определения возможностей нейросетей: эксперименты по различению, обобщению, по распознаванию последовательностей, образованию абстрактных понятий, формированию и свойствам «самосознания», творческого воображения и другие. Некоторые из этих экспериментов далеки от современных возможностей персептронов, поэтому их развитие происходит больше философски в пределах направления коннективизма. Тем не менее, для персептронов установлены два важных факта, находящие применение в практических задачах: возможность классификации (объектов) и возможность аппроксимации (границ классов и функций).

Важным свойством персептронов является их способность к обучению, причём по довольно простому и эффективному алгоритму

Сам Розенблатт выделил два фундаментальных ограничения для трёхслойных персептронов (состоящих из одного S-слоя, одного A-слоя и R-слоя):

- Отсутствие у них способности к обобщению своих характеристик на новые стимулы или новые ситуации;

- Неспособность анализировать сложные ситуации во внешней среде путём расчленения их на более простые.

В 1969 году Марвин Минский и Сеймур Паперт опубликовали книгу «Перцептроны», где математически показали, что персептроны, подобные розенблаттовским, принципиально не в состоянии выполнять многие из тех функций, которые хотели получить от персептронов. Его критику можно разделить на три темы:

1. Персептроны имеют ограничения в задачах, связанных с инвариантным представлением образов, то есть независимым от их положения на сенсорном поле и относительно других фигур. Такие задачи возникают, например, если нам требуется построить машину для чтения печатных букв или цифр так, чтобы эта машина могла распознавать их независимо от положения на странице; или если нам нужно определить из скольких частей состоит фигура; или находятся ли две фигуры рядом или нет. Минским было доказано, что этот тип задач невозможно полноценно решить с помощью параллельных вычислений, в том числе — персептрона.

2. Персептроны не имеют функционального преимущества над аналитическими методами (например, статистическими) в задачах, связанных с прогнозированием. Тем не менее, в некоторых случаях они представляют более простой и производительный метод анализа данных.

3. Было показано, что некоторые задачи в принципе могут быть решены персептроном, но могут потребовать нереально большого времениили нереально большой памяти. [1]

Заключение

Нельзя рассматривать нейронные сети как идеальное средство для решения любых задач, они отлично справляются там, где имеет место быть большое число похожих примеров, в которых можно проследить скрытые взаимосвязи, эта особенность успешно используется в областях с однотипным видом действий, требующих строго математического подхода. Однако не стоит их недооценивать, способность к обучению дает возможность расценивать нейронные сети как перспективное направление, и позволяет исследовать их потенциальные возможности в дальнейшем.

Список использованных источников

- Галушкин А.И. Нейронные сети. М.: Горячая Линия-Телеком, 2012. – 496 с.

- Горбань А., Росиев Д. Нейронные сети на персональном компьютере. М.: Наука, 1996. – 280 с.

- Минский, М., Пейперт, С. Персептроны. М: Мир, 1971. — 261 с.

- Мкртчян С.О. Нейроны и нейронные сети. СПб.: Питер, 2010. – 651 с.

- Нейронные сети в экономике. М.: LAP. – 80 с.

- Николенко С., Кадурин А., Архангельская Е. Глубокое обученение. Погружение в мир. СПб.: Питер, 2018. – 480 с.

- Рашид Т. Создаем разумную нейронную сеть. М.: Вильямс, 2018. – 272 с.

- Розенблатт, Ф. Принципы нейродинамики: Перцептроны и теория механизмов мозга = PrinciplesofNeurodynamic: Perceptrons and the Theory of Brain Mechanisms. — М.: Мир, 1965. — 480 с.

- Хайкин С. Нейронные сети. Полный курс. М. Вильямс, 2018. – 1104 с.

- Яхъева Г. Нечеткие множества и нейронные сети. М.: Бином, 2006. – 320 с.

- "Предмет, методы предпринимательского права и принципы предпринимательского права"

- Имущество как объект гражданских правоотношений (Понятие объектов гражданских прав)

- Особенности налогообложения налогом на прибыль кредитных организаций (Особенности исчисления и уплаты налога на прибыль)

- Реклама как сигнал информации (ГК «НАФТАН»)

- Имущественное налогообложение банков в РФ (Особенности налогообложения имущества банков в РФ)

- Реклама как сигнал и как информация (ГК «ЩАРА»)

- Природа и признаки ценных бумаг

- Баланс и отчетность (ОАО «Полоцкий агросервис»)

- Особенности налогообложения налогом на прибыль кредитных организаций (Система налогообложения)

- Мотивация в управлении на примере реально существующей организации (аспекты мотивации персонала предприятия)

- Построение организационных структур («АртДизайн»)

- Классификация логистических систем (Анализ действующих логистических систем)