Информация в материальном мире (ИНФОРМАЦИЯ В ЧЕЛОВЕЧЕСКОМ ОБЩЕСТВЕ)

Содержание:

Введение

В демократических государствах современной жизни невозможно представить без активного, упорядоченного движения и обмена информацией. В условиях свободного и открытого общества, с помощью информации граждане, лица без гражданства, государственные и общественные структуры удовлетворяют свои интересы, реализуют конституционные права и свободы.

Информация является интеллектуальным достоянием народа и государства, составной направлений и темпов реформирования экономики, административной системы, демократических преобразований, ресурсом общества, «который не должен теряться бесцельно и неэффективно» [12, с.198; 8, с.15; 18 с.198]. Количество информации в системе является мерой организованности системы [2, с.56].

Необходимо отметить, что информация существует в обществе с момента его зарождения, но предметом научных исследований такая важная субстанция как информация стала сравнительно недавно. К середине 20х гг. ХХ в. под информацией (в переводе с латинского informatio ознакомление, разъяснение, изложение) действительно понимали «сведения и сообщения», которые передаются устно, письменно или иным способом. И с развитием общества пришло понимание того, что объем понятия информация должна включать в себя все виды информации о живой и неживой природы, кибернетической техники и общественных процессах.

Проблемами информации, ее сущностью, процессами ее сбора, обработки, хранения, передачи, распространения ученые стали непосредственно заниматься только в ХХ веке. Развитие математических знаний в объяснении процессов передачи данных по каналам связи и появление прикладной теории информации, развитие биологии и генетики, появление кибернетики, теории систем и информатики обусловило становление термина «информация» как общенаучного понятия [2, с. 2437].

Информация стала предметом отдельной отрасли науки кибернетики (от греческого kybernetike искусство управления), которая представляет собой науку об общих чертах процессов и систем управления в технических устройствах, живых организмах и человеческих организациях. В кибернетике и информатике понятие информации тесно связанным с природой и функциями знаков и других символических форм.

Существует много научных определений понятия «информация», но большинство современных ученых в различных областях знаний вынуждены признать, что исчерпывающего понятия информации сформулировать невозможно, поскольку оно будет колебаться в зависимости от направлений научных исследований и задач, решаемых в каждой научно-прикладной ситуации. Одной из важных проблем современной науки, как уже отмечалось, является раскрытие понятия «информация», которое стало общенаучной категорией.

Объект работы- информация.

Предмет работы – положение информации в материальном мире.

Цель работы – проанализировать место информации в материальном мире.

Задачи работы:

- изучить понятие информации и ее развитие;

- проанализировать место информации в человеческом обществе;

- рассмотреть определение стоимости информации.

ГЛАВА1. ИНФОРМАЦИЯ КАК ОБЪЕКТ ИЗУЧЕНИЯ: ИСТОРИЧЕСКИЙ АСПЕКТ

1.1 Понятие информации

Слово «информация» происходит от латинского слова informatio, что в переводе означает информация, уточнение, знакомство. Понятие информации рассматривалось древними философами.

В повседневном смысле мы понимаем понятие информации почти одинаково и однозначно как информацию об окружающем нас мире, о явлениях и объектах, как знание чего-либо.

Нет единого определения этого термина для научного понимания информации. В различных научных дисциплинах и областях знаний информация описывается в собственной терминологии и имеет конкретные характеристики. Многие определения термина «информация» и различные представления о том, что такое информация, какова природа и сущность этого явления, уже накоплены и продолжают расти.

С точки зрения философии, «информация это отражение реального мира, информация это отраженное разнообразие, то есть нарушение единства.« Информация это одно из важнейших универсальных свойств материи ». [1]

В информатике это понятие определяется следующим образом: «Информация это вся информация, которая является предметом хранения, передачи и преобразования» [2].

В математике и кибернетике информация это количественная мера устранения неопределенности (энтропии), мера организации системы. [3]

«Отец-основатель» кибернетики, сам Н. Винер, утверждал, что информация это описание контента, который мы получили от внешнего мира, чтобы соответствовать нашим чувствам и нашим.

Согласно определениям в толковых словарях информация это содержание сообщения или сигнала; Информация, которая учитывается при передаче или восприятии с целью расширения знаний об объекте интереса [4].

Весь спектр представлений об информации более или менее четко соответствует двум основным понятиям:

· Информация является неотъемлемым свойством материи, ее атрибута («атрибутивная концепция»),

· Информация неотъемлемая часть самоуправляющихся (технических, биологических, социальных) систем, их функции («функционально-кибернетическая концепция»).

Определения и характеристики информации, представленной выше, практически соответствуют всестороннему пониманию информации, содержащейся в соответствующей статье Википедии [5]. Здесь говорится, что информация с позиции философии представляет собой набор фундаментальных, фундаментальных понятий, отражающих объективную реальность: материю, пространство, время, систематику, функции и т. Д. Информация является объективным свойством материи и ее свойств. Количество отражает. Информация - это особенность объекта. Это как другие свойства материи, такие как структура, движение, не имеет значения.

Информация объективна, существует независимо от нашего сознания и может существовать только в результате нашего взаимодействия с внешним миром посредством отражения, чтения, получения сигналов и так далее.

С материальной точки зрения информация - это последовательность объектов материального мира. Например, порядок букв на листе бумаги представляет собой письменную информацию в соответствии с определенными правилами. Последовательность генов в ДНК является генетической информацией и т. Д.

Кибернетика определяет объективную информацию как объективное свойство материальных объектов и явлений создавать множество состояний, которые передаются друг другу через другой процесс (материю) и запечатлеваются в его структуре.

В природе многие состояния системы являются информацией, сами состояния являются первичным кодом или исходным кодом. Таким образом, каждая материальная система является источником информации.

Кибернетика определяет субъективную (семантическую) информацию как значение или содержание сообщения. Информация - это особенность объекта.

Различные объекты (буквы, символы, картинки, звуки, слова, фразы, заметки и т. Д.), Которые были записаны, составляют основу информации. Информационное сообщение создается путем выбора копий объектов из базы и размещения этих объектов в пространстве в определенном порядке. Одно и то же информационное сообщение может быть выражено буквами, словами, предложениями, файлами, изображениями, заметками, песнями, видеоклипами и любой комбинацией всего вышеперечисленного.

Для обмена информацией необходимы необходимые и достаточные условия.

Требования: [6]

-· Наличие как минимум двух разных объектов материального или нематериального мира.

-· Наличие объектов с общим свойством, которое позволяет идентифицировать объекты в качестве носителя.

-· Наличие объектов с определенным свойством, которое позволяет отличать объекты друг от друга.

-· Наличие недействительной функции, позволяющей определить порядок объектов. Например, расположение информации, написанной на бумаге, является специфическим свойством бумаги, которое позволяет вам расположить буквы слева направо и сверху вниз.

Есть достаточное условие:

-· Наличие субъекта, способного распознавать информацию. Это общество людей и людей, общество животных, роботов и т. Д.

1.2 Этапы развития информации

Изобретение книгопечатания в Европе Иоаном Гутенбергом в середине XV века было, без сомнения, культурной революцией. Имело оно первостепенное значение и для науки: если раньше ученые обменивались своими идеями в письмах, то распространение книгопечатания не только ускорило процесс передачи информации, но и заметно расширило круг заинтересованных лиц.

В 60е годы XVII века начали учреждаться научные общества современного типа и возникать периодические научные издания. Таким образом. в дополнение к книгам, которые были единственной печатной формой научного продукта, появляются научные статьи. Первым научно-популярным журналом считается французский «Журна£ль дэ сава£н», который стал издаваться в январе 1665 года в Париже, публикуя различные новости научной жизни. По его образцу появились научные журналы и в других странах: «Философские труды» Лондонского Королевского общества в том же 1665 году; Acta eruditorum (Лейпциг, 1682) и пр. В России Академия наук с 1804 года начала издавать «Технологический журнал или Собрание сочинений и известий, относящихся до технологии и приложения учиненных в науках открытий к практическому употреблению», который стал первым отечественным журналом, посвященным проблемам техники и естественных наук.

Дифференциация научного знания и выделение в XIX веке из общего корпуса натурфилософии отдельных дисциплин привели и к специализации научных журналов. Так, в России с 1846 года начинают издаваться «Записки Императорского Русского географического общества»; c 1860 г.– «Филологические записки»; с 1879 года – «Русский филологический вестник»; с 1880 года – «Исторический вестник» и т.д. В ХХ столетии количество научных журналов заметно возрастает: в 1915 году появился журнал «Успехи физических наук», в 1932 году – «Успехи химии», в 1955 году – «Вопросы психологии», в 1957 году – «Информация по изобретательству» и другие. В середине этого века в связи с научно-технической революцией начался настоящий информационный бум. Количество специализированных научных журналов росло с каждым годом.

Стремительный рост объема научной информации поставил проблему ее систематизации. В 1952 году по инициативе акад. А.Н.Несмеянова в Москве был основан Всесоюзный институт научно-технической информации, начавший выпускать ежемесячные научно-технические сборники «Научно-техническая информация». В 1958 году американский исследователь Ю. Гарфильд создал Институт научной информации в США. Научная информация стала предметом специального изучения.

Важной вехой в исследовании информационных процессов стал 1955 год, когда была опубликована статья Ю. Гарфилда «Индекс цитирования в науке» [36], в которой он рассматривал цитирование в науке как показатель творческого взаимодействия. Этот показатель позволяет, в частности, на основе анализа социтирования авторов отслеживать возникновение новых дисциплин и именно эта функция (а не оценка продуктивности ученых) привлекла внимание к данному показателю со стороны научного сообщества. Указатель научных ссылок» стал регулярно публиковаться в Институте научной информации Гарфилда для составления «карт науки».

В 1959 году в Институте научной и технической информации АН СССР В.В. Налимовым, Г.Э. Влэдуцем и Н.И. Стяжкиным была опубликована статья «Научная и техническая информация как одна из задач кибернетики» [23], которая явилась первой отечественной публикацией по наукометрии (хотя термина такого еще не было). В этой статье рассматривались математические модели развития науки. Авторы, в частности, обращали внимание и на то, что в связи с экспоненциальным ростом науки меняется характер научной деятельности: примерно 50% своего времени научные работники тратят на поиск нужной информации. В связи с этим они выдвигали на передний план необходимость разработки новых эффективных средств информационной службы в целях продуктивной организации научных исследований. Позднее, в 70х годах, А.И.Михайлов, А.И.Черный и Р.С.Гиляревский выделили научно-информационную деятельность в качестве одной из составляющих научной деятельности (две другие составляющие – собственно исследовательская и научно-организационная деятельность), целью которой является снижение дублирования научных работ, и оптимизация деятельности ученых путем предоставления им нужной информации [20].

К 60м годам на Западе сформировалось особое научное направление «science of science» – исследования науки количественными методами1. Анализ изменений количественных показателей развития науки позволил выявить качественные изменения характера научной деятельности (возрастание доли коллективных исследований, совместных публика ций, времени, затрачиваемого на поиск нужной информации и др.). В октябре 1964 г. в Лондоне вышел сборник статей «Наука о науке», авторами которого были видные ученые Великобритании, США, Венгрии1. В нем выдвигалась идея актуальности превращения науки в объект специального изучения методами самой науки: речь шла, прежде всего, о количественных методах исследования. В эти же годы в СССР институализировалась новая научная дисциплина – науковедение, – одним из перспективных направлений которой стало исследование публикационной активности ученых количественными методами.

В июне 1966 года на Первом советско-польском симпозиуме по науковедению, проходившем во Львове и Ужгороде, В.В. Налимов выступил с докладом о количественных методах исследования науки. На этом симпозиуме он ввел термин «наукометрия», получивший впоследствии международное признание для обозначения направления количественных исследований публикационной активности ученых [см. 6, c. 167]. По следам выступления на симпозиуме в том же, 1966 году, в журнале «Вопросы философии» была опубликована его статья «Количественные методы исследования процесса развития науки», в которой поднимался фундаментальный вопрос о том, что измерять и как измерять, т.е. вопрос о выборе адекватных количественных показателей процесса развития науки [22].

С 1967 году под руководством В.В. Налимова в Институте истории естествознания и техники АН СССР начал работу общегородской семинар по наукометрии, оказавший большое влияние на развитие этого направления в нашей стране. В том же году вышла статья, выполненная коллективом авторов под общим руководством В.В. Налимова «Изучение научных журналов как каналов связи» [10], в которой давалась оценка вклада, вносимого отдельными странами в мировой научный поток. Эта оценка основывалась на сравнении двух показателей: 1) усилий, затрачиваемых той или иной страной на развитие науки (относительное число публикаций) и 2) эффективности этих усилий (относительное число библиографических ссылок на авторов рассматриваемых стран). Анализ данных показателей продемонстрировал низкую цитируемость советских ученых, что позволило авторам говорить о низкой эффективности советской науки – вывод, противоречащий общепринятой официальной позиции. В 1969 году совместно с З. Мульченко (его аспиранткой) В.В. Налимов опубликовал первую в мире монографию по наукометрии: «Наукометрия: Изучение развития науки как информационного процесса» [24]. В ней приводились кривые роста различных показателей развития науки; показатели цитирования, которые давали возможность для установления внутринаучных связей; проводилось всестороннее статистическое исследование конкретного научного направления (на примере анализа планирования экстремальных экспериментов); анализировалась проблема прогнозирования развития науки и пр. Авторы поднимали вопрос о создании специального информационного центра для статистического изучения процесса развития науки. В 1987 г. за свои работы в области наукометрии В.В.Налимов был удостоен медали Д. Прайса Международного общества по наукометрии и инфометрии.

В январе 1966 г. состоялся первый симпозиум «Применение количественных методов и вычислительной техники в исследованиях по истории научно-технического прогресса», организованный сектором истории техники и естествознания АН УССР, Советом по кибернетике и Советом по методологии науки АН СССР. Впоследствии эти симпозиумы проходили регулярно, объединяя лучшие силы не только СССР, но и стран Варшавского договора. Сектор «Истории техники и естествознания» АН УССР под руководством Г.М.Доброва внес весомый вклад в исследование науки количественными методами. В июне 1970 года в Москве прошел Международный симпозиум стран-членов СЭВ «Теоретические основы информации». В 1973 году в Талине, в 1976 – в Ленинграде (Репино), в 1979 – в Москве и Тбилиси состоялись Международные симпозиумы по теории информации. В августе 1978 года в Москве сотрудниками Библиотеки естественных наук и ВИНИТИ был организован семинар по ознакомлению советских ученых и информационных работников с изданиями американской фирмы Institute of Scientific Information.

В 60е годы в СССР наблюдался быстрый рост крупных информационных органов. Важным событием этого десятилетия было создание в 1969 году на основе Фундаментальной библиотеки общественных наук АН СССР Института научной информации общественных наук. Выпуская реферативные сборники по общественным наукам, в эпоху «железного занавеса» и информационного голода этот институт выполнял просветительскую функцию, знакомя советских ученых (из числа «избранных») с лучшими достижениями западной общественной мысли. В целях результативности организации научной деятельности чрезвычайно актуальной стала задача разработки новых эффективных средств информационной службы.

В 70е годы развивалась техническая база информационной службы: появился микропроцессор и был создан персональный компьютер. В Японии осуществили национальный проект создания ЭВМ пятого поколения. В качестве ответного шага крупнейшие американские фирмы объединились для создания научного центра, координирующего фундаментальные и прикладные исследования в области вычислительной техники. Тогда же здесь возникли и стали получать все большее распространение информационные сети. В Европе президент Франции Ф.Миттеран открыл Всемирный центр информации и людских ресурсов.

В СССР в 70е гг. был создан Координационный комитет по вычислительной технике под руководством Г.И.Марчука, в задачи которого входило создание сводных координационных планов по развитию вычислительной техники, разработке системного обеспечения и исследований в перспективных направлениях. Однако в эти годы число крупных информационных органов сохранилось практически неизменным, а к концу десятилетия даже наметилась тенденция снижения численности работников в области научной информации (хотя в два раза возросла доля работников высшей квалификации) [см. 28, с. 111, 112]. Это не коснулось только что созданного ИНИОНа, численность сотрудников которого в 70е годы интенсивно росла. В ИНИОНе возникла первая информационная система по общественным наукам.

Создание информационной базы научных публикаций явилось основой для разнообразных науко-метрических исследований. Работы по наукометрии Е.Д. Гражданникова, Ю.В. Грановского, Г.М. Доброва, В.В. Налимова, В.А. Маркусовой, И.В. Маршаковой публиковались в ежегоднике «Системные исследования» в выпусках «Материалы по науковедению» (Киев, СОПС УССР), «Науковедение и информатика» (Киев, Наукова думка).

На Западе одним из приоритетных направлений исследований этого периода были научные коммуникации. В 1970 году в СССР вышел перевод книги Л. Клейнрока «Коммуникационные сети» [11], а в 1976 году – сборника «Коммуникации в современной науке» [13]. У нас эта проблема также разрабатывалась, пересекаясь с работами по научной информатике. Так, авторы монографии «Научные коммуникации и информатика» предметом информатики считали «структуру и общие свойства научной информации, а также процессы научной коммуникации» [20, с.396], при этом информатику они вписывали в общую систему научных коммуникаций. Другой акцент делал А.Д. Урсул: он указывал, что информация стала общенаучным понятием, и центральную задачу информатики видел в разработке научноинформационной деятельности (научноинформационного обслуживания) с учетом научных коммуникаций [32, 33]. В 70е годы по проблемам информатики и научных коммуникаций выходила обширная литература: [см. 2, 3, 4, 5, 7, 9, 12, 14, 16, 26, 27, 29, 30, 31 и др.] В Киеве издавался республиканский межведомственный сборник «Науковедение и информатика». В московском университете проводились наукометрические исследования в области химии [см. 17]. В работе М.А.Берга «О возможности оценки тем научноисследовательских работ по информационным критериям» была предпринята попытка оценки сравнительной актуальности научных направлений по распределению спроса на научную литературу [1].

В 70е годы независимо друг от друга Г.Смоллом из Института научной информации в Филадельфии и И.В.Маршаковой из Москвы была выявлена сила связи двух элементов потока публикаций через определение числа общих для этих элементов ссылок [18, 38]. Маршакова назвала такую связь проспективной: сила связи двух элементов потока публикаций определяется числом работ, одновременно цитирующих эти элементы. Синхронные открытия расцениваются историками и методологами науки как назревшая необходимость логики развития научного знания в данном открытии. И действительно, данный показатель, введенный одновременно двумя учёными, стал активно применяться в наукометрических исследованиях для составления карт науки.

В середины 70х годов в нашей стране началось снижение информационной научно-технической базы, а к началу 80х годов подписка на иностранную литературу учреждений Академии наук сократилась на 36% [15, с. 15]. Это явилось одним из факторов отставания советской науки от мировой. Значимость проблемы была такова, что вопросы информационного обеспечения науки как важного фактора развития НТР были подняты на 27 съезде КПСС (1986 г.). Обсуждались они и на Всесоюзном совещании по философским и социальным проблемам науки и техники, проходившем в 1987 г. в Москве. Говорилось о необходимости освоения новых технических средства для обработки информации. С целью обеспечения Академии наук информацией о состоянии и перспективах развития фундаментальных исследований в СССР и за рубежом (прежде всего, для принятия решений, связанных с выбором приоритетных направлений исследований и формированием крупномасштабных программ) Президиум АН СССР принял решение о создании информационно-аналитической системы «Академинформ». В Институте системных исследований АН СССР была разработана концепция информатизации страны («Концепция информатизации советского общества»). В Институте истории естествознания и техники АН СССР издали сборник, в котором анализировался зарубежный опыт использования научно-технической информации, а также проблемы научных коммуникаций [8]. В 1986 г. журнал «Вопросы философии» организовал круглый стол «Социальные и методологические проблемы информатики, вычислительной техники и средств автоматизации», материалы которого были опубликованы в № 9 за тот же год. В июне 1988 г. в Тамбове прошла I Всесоюзная научная конференция «Информатика и науковедение». В эти же годы были опубликованы две фундаментальные монографии С.Д. Хайтуна, посвященные наукометрии [34, 35].

В последнее десятилетие прошлого века компьютерные технологии и интернет получили широкое распространение1, что привело к качественным изменениям в информационной сфере. Это потребовало специальных исследований проблем организации научно-технической информации, информационных потребностей ученых, организации справочно-информационного обслуживания. В 1991 году был создан научный Центр информатизации, социальных, технологических исследований и науковедческого анализа. В 90е годы появились специализированные периодические издания, освещающие проблемы информационного обеспечения науки: «Информатика и образование», «Информационные ресурсы России», «Проблемы информатизации» и др.

В связи с развитием компьютерных технологий и распространением интернета в новом ракурсе встала проблема научных коммуникаций. В 1992 году появляются публикации о глобальных коммуникационных сетях (RELCOM; EARN/ BITNET) как новом способе общения с коллегами, предоставляющим, в частности, возможности виртуального участия в международных конференциях [21].

В начала 90х годов стали популярны исследования сравнительной оценки вклада различных стран в развитие науки на основе статистической базы данных филадельфийского

Института научной информации National Science Indicators, в которой собраны библиометрические2 показатели ряда стран, начиная с 1981 года. Заметным событием этих лет стала монография И.В. МаршаковойШайкевич «Вклад России в развитие науки: Библиометрический анализ», где на основе библиометрической оценки вклада разных стран в развитие науки показано место России в научных достижениях. [19].

ГЛАВА 2. ИНФОРМАЦИЯ В ЧЕЛОВЕЧЕСКОМ ОБЩЕСТВЕ

2.1Проблема смысла информации

Говоря об информации, мы, как мыслящие существа, априори подразумеваем, что информация, помимо ее присутствия в форме принимаемых нами сигналов, также имеет смысл. Человек, который формирует в своем сознании модель окружающего мира как целостный набор моделей своих объектов и процессов, использует смысловые понятия, а не информацию.

Смысл - это сущность любого явления, которое не совпадает с ним и связывает его с более широким контекстом реальности. Значение - это концепция, которая описывает глобальное содержание утверждения. Само слово прямо указывает на то, что только мыслящие получатели информации могут формировать семантическое содержание информации. В человеческом обществе сама информация приобретает не решающее значение, а скорее ее смысловое содержание.

Способность мозга создавать смысловые понятия и отношения между ними является основой сознания. Сознание можно рассматривать как саморазвивающуюся семантическую модель мира.

Смысл - это не информация. Информация существует только в материальных СМИ. Человеческое сознание считается нематериальным. Значение существует в человеческом разуме в форме слов, образов и ощущений. Человек может не только произносить слова вслух, но и «себе». Он также может создавать (или восстанавливать) неподвижные изображения и ощущения. Тем не менее, он может восстановить информацию, которая соответствует этому значению, сказав или написав слова.

Информация содержится в мозге в виде определенных состояний его нейронов. Он также включен в печатный текст, состоящий из этих слов. Информация, которая восстанавливается таким способом, называется семантической информацией, потому что она кодирует значение некоторой первичной информации.

Когда кто-то слышит (или видит) фразу, на которой говорят (или пишут) на языке, который он не знает, он получает информацию, но не может определить его значение. Поэтому для передачи семантического содержания информации требуются некоторые соглашения между источником и приемником относительно семантического содержания сигналов, то есть слов. Такие соглашения могут быть заключены в процессе общения, т.е. в процессе, который включает в себя не только обмен информацией (общение), но и обмен конкретными действиями (взаимодействие) и действиями по взаимному восприятию и взаимопониманию партнеров (социальное восприятие).

Сообщение включает в себя следующие информационные процессы:

· Хранение информации

· Передача информации

· Обработка информации

Информация хранится путем ее передачи на материальный носитель. Носителем данных может быть любой объект, с которого может (но не обязательно) считываться существующая (записанная) информация. Носители заряда по своей природе подразделяются на волновые поля (звук, электромагнитные волны и т. д.), материалы (книги, письма, аппаратные устройства хранения и т. д.) и биохимические (ДНК, РНК и т. Д.). по происхождению - натуральный и искусственный.

Передача семантической информации - это процесс ее пространственной передачи от источника к месту назначения (месту назначения). Для передачи информации (как физического процесса) требуются следующие компоненты: 1) источник информации; 2) получатели информации; 3) носитель информации; 4) средство ее передачи и 5) правила и методы применения и удаления информации от «носителя», заранее известного «источнику» и «получателю». Язык - это метод передачи, который используется в непосредственном контакте (разговоре) от древности до современности.

Для того, чтобы передавать информацию на большие расстояния, необходимо, чтобы информация была оформлена (показана) каким-либо образом. Информационные системы используют различные системы символов - наборы предопределенных семантических символов: объекты, изображения, письменные или печатные слова естественного языка. Семантическая информация об объекте, явлении или процессе, представленная с его помощью, называется сообщением.

Обработка информации (если она несущественна) состоит из различных преобразований. Процессы обработки включают в себя любую передачу информации с одного носителя на другой. Информация, предназначенная для обработки, называется данными. Основным способом обработки первичной информации является ее преобразование в форму, обеспечивающую ее восприятие человеческими чувствами.

Наиболее важным способом обработки семантической информации является определение значения (контента), существующего в сообщении. В отличие от первичной семантической информации, статистические характеристики не имеют, то есть количественной меры - значение либо есть, либо нет. И сколько из этого, если оно есть, определить невозможно. Значение, содержащееся в сообщении, описано на искусственном языке, который отражает семантические связи между словами исходного текста. Словарь такого языка, так называемый тезаурус, находится в получателе сообщения. Значение слов и фраз сообщения определяется путем их присвоения определенным группам слов или фраз, значение которых уже определено. Таким образом, тезаурус позволяет определить смысл сообщения, одновременно заполняя его новыми семантическими понятиями.

2.2 Классификация информации

Информация может быть разделена на типы по различным критериям:

- по методу восприятия:

Визуально - воспринимается органами зрения.

Аудиально - воспринимается органами слуха.

Тактильно - воспринимается тактильными рецепторами.

Обоняние - Обнаружены обонятельными рецепторами.

Вкус - воспринимается вкусовыми рецепторами.

- по форме представления:

Текстом - в виде символов, предназначенных для идентификации языковых маркеров.

Числовой - в виде цифр и знаков, обозначающих математические действия.

Графический - в виде изображений, объектов, графики.

Звуковой - словесный или в виде записи, передача речевых монет акустическим способом.

- по договоренности:

Массовая - содержит тривиальную информацию и работает с набором концепций, которые понятны для большинства общества.

Специальная - содержит ряд конкретных концепций, которые при использовании передают информацию, которая может быть непонятной для большинства общества, но которая необходима и понятна в узкой социальной группе, в которой эта информация используется.

Личная - это совокупность информации о человеке, определяющая социальный статус и тип социальных взаимодействий внутри населения.

- по значению:

Актуальная - информация, которая является ценной в данный момент.

Достоверная - информация получена без искажений.

Понятная - информация на языке, понятном человеку, для которого она предназначена.

· Полная - информация, достаточная для принятия правильного решения или понимания.

· Полезная - полезность информации определяется субъектом, который получил информацию, в зависимости от объема использования.

По истинности:

Правдивая;

Ложная.

Как показывает анализ литературы, понятие и термин «коммуникация» неотделимы от термина и термина «информация». В любом случае, он содержит десятки и сотни определений общения, содержащихся в различных словарях, энциклопедиях, популярных и научных работах. Они фиксируют тот факт, что общение это:

· Передача информации от человека к человеку,

· Акт передачи информации,

· Процесс передачи информации из одной системы в другую,

· Обмен информацией любого рода между различными системами связи,

· Доставка сообщений, сообщение,

Передача информационных сигналов, символов, как вербального, так и невербального общения,

· Информационное взаимодействие,

· Обмен людьми между собой разными идеями, идеями, интересами, настроениями, чувствами, взглядами,

· Переместить что-нибудь, включая информацию, сообщение, сигнал, значение и т. Д.

· Тип взаимодействия лиц, участвующих в обмене информацией.

· Обмен деловой информацией и т. Д.

По нашему мнению, ряд авторов в своих определениях подчеркивают, что общение - это не просто обмен информацией, а информационное взаимодействие.

- семантический аспект социального информационного взаимодействия;

- семантический и, в идеале, значимый аспект социального взаимодействия.

- процесс передачи (обмена) содержимого, содержащегося в сообщении (информации).

Поэтому мы подчеркиваем, что социальная коммуникация - это именно семантическая, идеально-смысловая сторона, аспект информационного взаимодействия субъектов. Более того, решающее значение имеет не физическое пространство и время, в которое происходит общение, а социальное пространство и социальное время его осуществления.

Для человека информация сама по себе не важна, но ее семантическое содержание, характеристики и ценность, которые становятся видимыми только тогда, когда полученная информация является доступной, понятной и значимой.

Когда кто-то слышит или видит фразу, произнесенную или написанную на языке, который он не знает, он получает информацию, но не может определить свое значение и правильно ее использовать. Такое общение бессмысленно и не дает ожидаемого результата. Чтобы избежать этого, необходимо сопоставить семантическое содержание слов или других символов, содержащих содержание и значение информации, с правилами для кодирования информации.

Поэтому, когда мы говорим об отношениях между информацией и общением, мы предполагаем, что общение - это движение (передача, обмен) информации, но не каждое такое движение - это социальное общение. Отсюда следует, что наиболее важным признаком человеческого общения является движение, передача или обмен значениями между партнерами по общению.

ГЛАВА 3. СТОИМОСТЬ ИНФОРМАЦИИ

Информация об объекте – величина, определяемая множеством термов (знаков, символов, сигналов), отображающих на заданном языке состояние, свойства и структуру объекта и зафиксированных на том или ином носителе.

Структура объекта отображается подмножеством его элементов и связей.

-

- материальные, и абстрактные объекты можно представить как множество U частей (фрагментов, элементов) объекта и множество R связей (отношений) между частями. Связи обеспечивают целостность и тождественность объекта самому себе. Пару множеств U и R называют [1] структурной системой объекта или просто структурой и обозначают SS.

Элементами структур могут быть материальные и идеальные объекты различной природы. В химии и физике в качестве частей объекта рассматривают химические элементы, вещества, кристаллические ячейки, фазы. Соответственно множество U этих частей и множество R связей между ними составляют химическую структуру. В статистической физике объект рассматривается как ансамбль большого числа взаимодействующих молекулярных подсистем. В лингвистике слова и высказывания формируют структуры текста. В информатике тематики формируют структуры областей знания.

Принципиальная трудность теории систем состоит в том, что строгий критерий членения объекта на части отсутствует. В качестве такого критерия предложен принцип энергетической дифференцировки [2], основанный на схеме иерархической организации природы.

В химических и физических исследованиях иерархичность выявляется при членении объектов на фазы, молекулы веществ, образующих эти фазы, атомы, из которых состоят молекулы. В биологии биоценоз подразделяют на популяции, популяции состоят из организмов, организмы состоят из совокупности тканей и клеток, клетки образуются из молекул.

В информационных проектах иерархичность выявляется при членении информации по разделам, областям.

В 1907 г. Американское химическое общество Chemical Abstracts Service (CAS) начало издавать реферативный журнал «Chemical Abstracts» (CA). В мире существуют два общехимических реферативных журнала – «Chemical Abstracts» и РЖ «Химия». Первоисточниками для СА служат около 12 тыс. научных и технических журналов на 50 языках, патенты 28 стран, а также материалы конференций, диссертации, книги. Всего имеется 80 рубрик: Биохимия (120); Органическая химия (2134); Высокомолекулярные соединения (3546); Прикладная химия и химическая технология (4764); Физическая, неорганическая и аналитическая химия (6580).

С 1953 года ВИНИТИ издаёт Реферативный журнал (РЖ) по различным областям науки и техники. В более 200 тематических выпусках журнала публикуются рефераты на основе обработки около одного миллиона документов (диссертаций, журналов, книг) ежегодно из 130 стран мира на 66 языках в области точных, естественных, медицинских и технических наук.

РЖ разделен на 24 сводных тома (191 выпуск) по разделам наук (остальные 41 выходят отдельными выпусками) по 21 областям науки и техники от Автоматики и вычислительной техники до Энергетики.

Множества частей U и связей R структуры SS изучаемого объекта подразделяют на подсистемы некоторого низшего уровня. Затем формируют подсистемы высших уровней (ярусов, слоев, классов), В РЖ и CA это тематические выпуски.

На каждом следующем более высоком уровне элементами служат системы предыдущего уровня, а элементарными актами являются генеральные процессы предыдущего уровня. Так продолжается вплоть до структуры SS объекта в целом. Получают распределение подсистем по уровням, отображаемое системой вложенных подмножеств:

Uj Uj+1 Uj+2 … U SS , (1 3).

где Uj – подмножество наименьших элементов системы SS, U — множество наиболее крупных элементов той же системы.

Чтобы подчеркнуть сложность так называемых элементарных подсистем, вводится понятие унитарная структура или униструктура, как эквивалент понятия элемент данного уровня [2].

Связанной, или структурной информацией об объекте, называется величина, определяемая совокупностью термов, отображающих подмножество его элементов и связей с заданной точностью.

Связанная информация есть мера структурной сложности объекта. При этом сложность систем возрастает с увеличением числа типов элементов Uj,k (униструктур), и числа связей R.

Например, в химии и физике можно считать, что любой материальный объект состоит из частиц трех видов: протонов, нейтронов, электронов. Эти частицы, связанные в различных сочетаниях ядерными и электрическими силами, образуют атомы более 100 химических элементов. Эти же частицы, соединенные в атомы углерода, водорода и кислорода с помощью химических связей, формируют молекулы органических веществ.

Методы измерения сложности объектов

Предложены разные методы количественного измерения сложности объектов. Любая мера структурной сложности представляет собой функцию, отображение структуры объекта. Общие свойства этой функции могут быть сформулированы в виде восьми аксиом (А0–А7).

В теории связи некоторое множество передаваемых символов называют сообщением. По Шеннону [3, 4] количество информации Н в сообщении рассчитывается по обобщенной формуле Хартли:

= kS(р1 lоg2р1 + р2 lоg2p2 + ...+ рп lоg2pn), (2 1)

где p1, p2, …, pn — вероятности (частоты) передачи по каналу связи одного из n возможных сообщений, kS— постоянная Шеннона, зависящая от выбора единиц измерения информации.

Термодинамическую энтропию S рассчитывают по Формуле Больцмана:

S= kB(w1 lоg w1 + w2 lоg w2 + ...+ wn lоg wn), (3 2)

где w1, w2, …, wn — вероятности состояний термодинамической системы, kB =1,38. 1023 Дж/К — постоянная Больцмана.

Аналогия формул (2) и (3) очевидна. Однако адекватный критерий для оценки связи количества информации c сопряженными энергетическими затратами и приращением термодинамической энтропии не известен. Чтобы установить такой критерий необходимо найти конструктивное определение информации. В данной работе аксиоматически вводятся понятия, на основе которых можно построить эвристическую концепцию.

Принцип дифференцировки и квази-разложимость структуры объекта Формализованное описание сложных объектов доступно рассмотрено в работе [5]. Сложные объекты непротиворечиво описываются с помощью теории множеств по Расселу Уайтхеду [6].

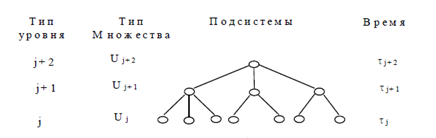

Каждому объекту соотносят тип. Во множество могут входить объекты лишь одного типа, например, типа j (рис. 1). Тогда само множество является объектом типа j+1 и в то же время может быть элементом множества типа j+2, и т.д.

Рис. 1. Иерархия типов объектов системы

Множества униструктур в этой теории образуют иерархию типов. Структура объекта и соответствии с вышесказанным определяется как множество R отношений, заданных на множестве U униструктур этого объекта. Индивидуальность объекта определяется типом элементов множества U и свойствами отношений множества R, в частности, количественными характеристиками связей между элементами. Поэтому для построения иерархии типов элементов естественно в качестве эмпирического критерия использовать принцип дифференцировки по энергии связей.

Пусть исходный объект состоит из униструктур Uj,k, между которыми могут возникать как сильные, так и слабые взаимодействия. Через некоторое время сильные связи исчерпываются. При этом образуются надструктуры j+1 (рис. 1) как комбинации исходных униструктур j.

В химии из атомов образуются различные молекулы, в информационных массивах формируются различные темы. Затем за счет менее сильных связей может произойти агрегация надструктур j+1 в надструктуры более высокого порядка j+2 (образованные молекулы ассоциируют, темы объединяются). В результате формируется иерархическая структура объекта.

При дозированных воздействиях на материальный объект происходит его декомпозиция. В соответствии с реальной процедурой декомпозиции можно провести мысленную декомпозицию (квазиразложение) объекта на униструктуры разных типов.

Принцип дифференцировки по силе связи формулируется следующим образом: сила связей между униструктурами данного уровня (сильные связи) существенно выше силы связей между соответствующими однотипными надструктурами (слабые связи).

Формально принцип дифференцировки можно записать в виде: Еj ›› Еj+1 , (4)

где Еj+1 – мера силы связи между элементами уровня j+1 (субструктуры), Еj – мера силы связи между элементами более высокого уровня j+2 (надструктуры, рис. 1).

Для использования соотношения (4) необходимо найти меру силы или прочности связи между элементами.

Связь – это взаимодействие, отношение между объектами, путем обмена энергией, веществом, информацией. Соответственно различают связи: энергетические, материальные, информационные (инфосвязи).

Сила обменной связи между объектами измеряется потоками вещества и энергии от одного объекта к другому. Частный случай обменных связей – информационные связи. Следует отметить, что потоки вещества, энергии и информации сопряжены между собой.

Cложность объекта и связанная информация (память)

Наряду с шенноновским определением информации, на практике используют много других способов. Формула (1) разработана и хорошо приспособлена для оценки переданной информации, но не для расчета запасенной в памяти или связанной информации.

Состояние объекта определяется множеством данных о структуре, состоящим из подмножества частей и связей объекта и подмножества свойств этих частей и связей.

Изменение (движение) объекта представляется как изменение его состояния в виде зависимости набора данных от времени. Формально состояние объекта может быть описано множеством функций fi(q, t), где q – набор переменных состояния, t – время. Кодирование функций fi(q, t) на заданном языке и их передача – основа инфо-взаимодействия.

Информация об объекте – величина, определяемая множеством термов (знаков, символов, сигналов), отображающих на заданном языке состояние объекта и зафиксированных на том или носителе.

Структура объекта отображается подмножеством его частей и связей.

Связанной или структурной информацией об объекте называется величина, определяемая совокупностью термов, отображающих подмножество его частей и связей с заданной точностью [3]. Т.о. связанная информация есть мера структурной сложности объекта.

Интуитивно понятно, что сложность систем возрастает с ростом числа униструктур и числа классов (типов) элементов, эквивалентных по какомулибо признаку.

Предложены разные методы измерения сложности [7]. Любая мера сложности есть функция, отображение структуры объекта. Общие свойства этой функции могут быть сформулированы в виде 7 аксиом (А0А6).

А0. Совокупность униструктур U любого объекта может быть разбита по данному признаку на подмножества Uj эквивалентных униструктур, называемых смежными классами, слоями или частями. А1: Сложность пустого множества равна нулю. А2: Сложность класса Uj униструктур не может быть выше сложности множества U всех униструктур объекта, часть которого составляет этот класс. А3: Если имеется однозначное соответствие (гомоморфизм) между униструктурами множества Ui и униструктурами множества Uj, сложность Ui не выше сложности Uj.

А4: Если имеется взаимооднозначное соответствие между униструктурами множеств Ui

Uj, сложности этих множеств равны. А5: Сложность объекта, состоящего из нескольких, не связанных между собой частей (не имеющих общих униструктур), равна сумме сложностей этих частей.

А6: Сложность минимального элемента равна нулю.

Иллюстрация аксиомы А3 – постулат одинаковых устройств: сходство и различие объектов определяются сходством и различием как частей, так и связей, образующих структуру объектов. Широко используемое аналоговое моделирование – одно из следствий постулата одинаковых устройств.

По аналогии с формулой (1) связанная структурная информация или сложность объекта S равна:

C(S) = (f1log2f1 +f2log2f2 +… + fn log2fn) = ∑fklog2fk (5)

Здесь fk – частота униструктур типа k, определяемая равенством fk =Nk/N0, N0 – общее число униструктур, на которые разлагается объект S; Nk числа униструктур типа k; N1, …, Nn – числа униструктур типа 1, 2,..., n; log2 fk – логарифмы при основании 2.

Число и вид связей, принадлежащих множеству R структуры, не входят в формулу (5).

Косвенно эти характеристики учтены числом и видом униструктур.

Нетрудно проверить, что сложность, рассчитываемая по формуле (5), удовлетворяет требованиям аксиом (1-6).

Несмотря на формальное сходство выражений (3) для энтропии и (2) для информации между ними имеется глубокое принципиальное различие. В формуле (3) постоянная Больцмана kB определяет энтропию как наблюдаемую величину – суммарную приведенную теплоту, полученную объектом в процессе формирования данного равновесного состояния. Информация, рассчитываемая по формуле (2), безразмерная величина, определяемая числом бит, необходимых для описания множества свойств объекта в данном состоянии.

Очевидно, что любые объекты, состоящие из N одинаковых элементов, содержат согласно (2) одну и ту же связанную информацию имеют сложность, равную log2N (аналог формула Больцмана в статистической физике).

Интуитивно понятно, что связанная информация биологического сообщества выше, чем организма, входящего в это сообщество, а связанная информация организма выше, чем его химического состава. Однако, расчет по формуле (5) дает близкие по порядку величины значения. Противоречие снимается, если учесть, что как объекты, так и фрагменты, на которые они разделены, имеют разную сложность, относятся к разным типам (рис. 1).

Например, биогенные вещества состоят из разных молекул с различным атомным составом. Органы животного строятся из разных тканей, которые состоят из разных молекул, различным образом связанных между собой. Биологические сообщества состоят из популяций разных видов, популяции – из разных особей и так далее до молекул.

Сложность объекта можно учесть, если представить его в виде иерархии более мелких униструктур (рис. 1). С этой целью в формулу (5) вводят дополнительные слагаемые и получают обобщенное выражение для связанной информации объекта S:

C(S)=(Σ fklog2fk + Σfkllog2fkl +… + Σfklmlog2fklm), (6)

где fk ,fkl ,fklm – частоты униструктур типа k, kl, klm, равные fk=Nk/N0, fkl =Nkl/Nk , fklm =Nklm/Nkl , где N0 – общее число наиболее крупных униструктур обьекта S; Nk, Nkl, Nklm – числа более мелких униструктур типа k; kl, klm , на которые делится каждая униструктура предыдущего уровня (рис.1).

Кинетика информационных процессов

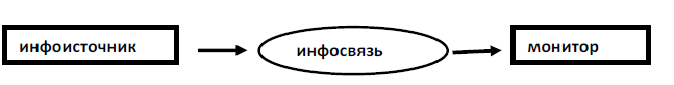

Информационная цепь (инфоцепь) – система, обеспечивающая поступление информации от объекта к приемнику [10]. Частные случаи инфоцепи – различные системы связи [2].

Информационный поток (инфопоток) – величина, измеряемая скоростью передачи информации в инфоцепи. Передача информации между частями цепи осуществляется через информационные контакты.

Информационный контакт (инфоконтакт) – система из двух элементов: источника информации (инфоисточник) и приемника (монитора), на котором регистрируется поступающая информация (рис. 2). Очевидно, что самая короткая инфоцепь состоит только из двух звеньев — инфоисточника и монитора, соединенных инфосвязью — передаваемой информацией.

Рис. 2. Структура информационного контакта

Получение информации можно рассматривать как аналитическую процедуру.

При качественном анализе устанавливают типы униструктур и связей объекта.

При количественном – определяют доли униструктур и связей разных типов.

Химик при качественном анализе определяет химические элементы, молекулы, фазы вещества, составляющие тело. Эколог изучает биологические особи, виды, популяции, образующие сообщество, а также химический состав среды обитания.

При количественном анализе тех же объектов измеряют число разных униструктур, установленных при качественном анализе этих объектов.

Для получения информации необходим канал наблюдения – устройство и процедура для регистрации термов – знаков, сигналов, отображающих структуру объекта и его состояние [1, 2, 4].

В технике каналы наблюдения оформляются в виде приборов разной сложности. Органы чувств – природные каналы наблюдения животных.

В результате инфоконтакта информация о структуре инфоисточника (сообщение) отображается как связанная информация приемника – монитора.

Передаваемая информация – явление отличное от связанной информации. Сходное отношение имеется между внутренней энергией тела и передаваемой энергией от тела другим телам. Но данная аналогия существенно ограничена.

Для энергии выполняется закон сохранения: внутренняя энергия тела убывает ровно на сумму совершенной работы и переданной теплоты. Связанная информация источника при взаимодействии также убывает, но эта убыль зависит от степени нарушения структуры инфоисточника при контакте с монитором.

Не инвазивные методы, интроскопические каналы наблюдения практически не затрагивают структуру изучаемого объекта. В то же время многие методы анализа приводят к полному разрушению образца и потере связанной информации.

Количество информации, переданной от объекта S на монитор (сообщение), рассчитывают по формуле I(S)=(Σftklog2ftk +Σftkllog2ftkl +…+Σftklmlog2ftklm) ( 7 )

Здесь ftk,ftkl,ftklm – частоты униструктур типа k, kl, klm, по транслированной информации равные ftk =Ntk/Nt0, ftkl =Ntkl/Ntk, ftklm =Nt klm/Nt kl , где Nt0 – общее число наиболее крупных униструктур обьекта S; Ntk, Ntkl, Ntklm – числа более мелких униструктур типа k, kl, klm, определенные по каналу наблюдения (см. рис 1, 2).

Аксиома 7: сущность любого объекта, его целостность не меняется пока и поскольку числа и частоты униструктур высших уровней остаются постоянными (Nj+1, Nj+2 рис. 1), а изменяются (генеральный процесс) лишь числа менее сложных униструктур (Nj . рис.1).

Относительно простые уравнения, описывающие динамику сложных объектов, получают с помощью агрегированных характеристик, то есть таких величин, которые описывают объект в целом [8]. В теории систем и термодинамике это функции состояния. Агрегированные переменные входят в кинетические уравнения, описывающие изменение этих переменных, а, следовательно, объекта в целом, со временем.

Кинетика связанной информации C(t) описывается уравнением:

dC/dt=kc( Σ(1n efk)dfk/dt +Σ(1n efkl )dfkl/dt +Σ(1n efklm)dfklm/dt), (8)

где dC/dt – скорость изменения структуры объекта; kc =1/ln2; fklm, fklm, fklm частоты униструктур вида k, kl, klm (см. формулу (7)); dfk /dt, dfkl /dt, dfklm /dt – скорости изменения этих частот.

Кинетика передаваемой информации I(t) описывается уравнением:

dI/dt= kc (Σ(1n e f tk)df tk/dt+Σ(1n e f tkl )+Σ(1n e f tklm)df tklm/dt ) (9)

Аксиома 7 облегчает мониторинг сложных объектов. Частоты высших униструктур, определяющих самотождественность объекта, не меняются, а скорости их изменения равны нулю. Поэтому для получения информации о состоянии объекта достаточно следить лишь за генеральным процессом. Например, если числа Nk и Nkl не меняются, уравнение (10) принимает вид:

dC/dt= kc Σ(1n efklm)dfklm/dt, (10)

где fklm – частоты униструктур третьего нижнего уровня (рис. 1), скорости изменения которых dfklm /dt отображают динамику генерального процесса.

Например, при контроле состояния животного можно ограничиться пищеварительной, кровеносной и нервной системами. Животное жизнедеятельно, пока сохраняются в целостности эти три его системы, части и ткани этих систем. Сами ткани в известных пределах могут изменяться в ходе жизнедеятельности. Т.е. генеральный процесс идет на четвертом сверху уровне.

Энергетическая и материальная стоимость информации

Согласно (8) скорость изменения структуры объекта определяет поток информации от источника к монитору. Чтобы определить потоки вещества и энергии, переносящие информацию, необходимо рассчитать парциальную материальную Km или парциальную энергетическую KE стоимость информации, которые определяются формулами:

Km = ∆m/∆I , (11) KE = ∆E/∆I (12)

где ∆m , ∆E – масса и энергия, затраченные на перенос информации ∆I.

Затраты вещества и энергии на перенос информации определяют по формулам:

∆m =Km∆I, (11a) ∆E = KE∆I, (12a)

Парциальные стоимости информации Кm и KE являются функциями устройства инфоконтакта, а также способа передачи информации. Поэтому парциальная стоимость информации – величина нетермодинамическая, и, следовательно, связь информации с термодинамической энтропией, если и существует, то опосредованная. Формально эту связь можно представить, например, следующим образом.

Можно считать, в соответствии с термодинамическим определением, что приращение энтропии приемника равно ∆S = ∆E/T, где T – температура приемника. Тогда из (12а) получают связь энтропии и информации: ∆S = KE∆I/T , (13)

где KE/T – искомый коэффициент для оценки приращения термодинамической энтропии с количеством переданной информации.

Следует отметить, что стоимость информации, определенная по (11) и (13) не зависит от единиц измерения информации. Важно лишь, чтобы мера информации удовлетворяла аксиомам 1-6 и была однозначной функцией. Пересчет на денежную стоимость проводится на основе прейскурантов.

Если структура известна, ее описание, с точки зрения теории информации, эквивалентно некоторому тексту. Словами этого текста служат символы, обозначающие элементы данной структуры. В рассмотренном примере иерархической структуры (схема 1) это Uk,Ukl,Uklm, соответствующие уровням j+2, j+1, j. Для кодировки элементов минимально требуется: для уровня (j+2) – три буквы (цифры), (j+1) – пять букв, уровень j –семь букв. Соответствующая информация для полного описания трех уровней составляет величину, равную (байт):

∆I(S) = 3Σ Nk + 5Σ Nkl +… + 7Σ Nklm, (14)

Энергетическая стоимость информации согласно (12a) равна ∆E=KE∆I, где KE – стоимость передачи одного байта.

В сложных объектах отдельные инфоконтакты соединены в информационные цепи. Эти цепи образуют петли обратных связей, циклы, сети. Их можно отобразить в виде графа.

Поведение природных регуляторных систем отображает многие общие свойства технических информационных сетей, и представленная здесь процедура может применяться для высокоорганизованных объектов, так называемых организменных технических систем [9, 10].

Заключение

Информация является одним из важнейших универсальных и неотъемлемых свойств материи. Это отражение реального мира, отраженное разнообразие, деноминация содержания. Информация существует в каждом материальном объекте или процессе в виде множества его состояний и передается от объекта к объекту в процессе их взаимодействия.

Для передачи информации (связи) необходимо наличие материального носителя информации и набора характеристик у источника и приемника информации, обеспечивающих реальное информационное взаимодействие.

Информация объективна, но несущественна. Он существует независимо от нашего сознания и существует в нем только в результате нашего взаимодействия с внешним миром. На уровне домохозяйств информация - это информация, знания, которые являются предметом хранения, передачи и преобразования.

Информация в виде полученных нами сигналов имеет конкретное значение, определенное в терминах (словах) и других формах. Смысл это не информация. Если информация существует только на материальном носителе, то смысл существует в человеческом разуме в форме слов, образов и ощущений. Они представляют вторичную или семантическую информацию, которая кодирует смысл полученной первичной информации

В человеческом обществе важна не сама информация, а ее семантическое содержание. Человек использует в своей деятельности именно смысловые понятия, содержание сообщения, а не информацию «в целом» как таковую.

Для передачи семантического содержания информации, помимо прочего, требуются общие правила взаимодействия информации между источником и получателем, которые определяются в процессе общения.

Методом обмена информацией являются различные системы знаков, и особенно язык, и другие средства передачи информации.

Список литературы

- Берг М.А. «О возможности оценки тем научно-исследовательских работ по информационным критериям» \\ Теория и практика научно-технической информации. – М.: МДНТП, 2015. – С.144-150

- Блек А.В. Информационное обеспечение научных исследований. М.: ИНФРА, 2014. – 151 с.

- Бородыня В.И. Информация и научно-технический прогресс. СПБ: Речь, 2014. – 21 с.

- Виноградов В.А. Общественные науки и информация. М.: ИНФРА, 2014 – 263 с.

- Гиляревский Р.С. Информатика и библиотековедение. Общие тенденции в развитии и преподавании. М.: ИНФРА, 2015. – 204 с.

- Грановский Ю.В. Можно ли измерять науку? // Науко-ведение. М., 2012. № 1. – 160–183.

- Добров Г.М., Коренной А.А. Наука: информация и управление (Информационные проблемы управления наукой). М.: Кнорус, 2014. – 256 с.

- Зарубежная практика оперативного использования научнотехнической информации / Отв. ред. А.Н. Кривомазов. М.: ИИЕТ АН, 1998. – 206 с.

- Злочевский С.Е. Информационные коммуникации в современной науке. М.: Дашков и К, 2014. – 40 с.

- Изучение научных журналов как каналов связи / Баринова З.М., Васильев Р.Ф., Грановский Ю.В., Мульченко З.М. и др. // Научно техническая информация, Сер. 2. – М., ВИНИТИ, 1997, № 12.С. 3–11

- Клейнрок Л. Коммуникационные сети / пер. с англ. под ред. А.А.Первозванного. М.: ИНФРА, 2015. – 255 с.

- Козачков Л.С. Системы потоков научной информации. М.: Кнорус, 2013. – 200 с.

- Коммуникации в современной науке / пер. с анг. сост., ред. Э.М.Мирский и В.Н.Садовский. М.: Прогресс, 2016. -438 с.

- Концепция информатизации советского общества / Под ред. Д.М. Гвишиани. М.: ВИНИСИ. Препринт, 1990. – 54 с.

- Лебин Е.Д., Цыпкин Г.А. Права работников науки. Спб. : Речь, 2014. – 226 с.

- Левштейн М.И. Современные методы и средства выпуска информационных изданий. М.: ИНФРА, 2014. – 95 с.

- Логика развития и наукометрический анализ отдельных направлений в химии \ отв. ред. В.А.Кабанов, Ю.В.Грановский. М.: МГУ, 2014. – 134 с.

- Маршакова И.В. Проспективная связь в системе научных публикаций \\. М.: ИНФРА, 2015. – С.3854

- Маршакова-Шайкевич И.В. «Вклад России в развитие науки: Библиометрический анализ». М.: ТОО «Янус», 2015. – 248 с.

- Михайлов А.И., Черный А.И., Гиляревский Р.С. Научные коммуникации и информатика. М.: ИНФРА, 2016. – 435 с.

- Мирская Е.З., Шапошник С.Б. Компьютерные коммуникации в российской науке // Вестник Академии наук. М. 2015, С. 203-213.

- Налимов В.В. Количественные методы исследования процесса развития науки // Вопросы философии. – М., 2016. № 12. – С. 38–47

- Налимов В.В., Г.Э. Влэдуц Г.Э., Стяжкин Н.И. Научная и техническая информация как одна из задач кибернетики». М., 1999, т. 69, № 1. –13–56.

- Налимов В.В., Мульченко З.М. Наукометрия: Изучение развития науки как информационного процесса. – М.: ИНФРА, 2014. – 192 с.

- Наука о науке / Под ред. В.Н. Столетова. – М.: Прогресс, 2016. – 422 с.

- Новиков Э.А., Егоров В.С. Информация и исследователь. Спб. : Речь, 2014. – 189 с.

- Об эффективности научно-информационной деятельности / ред. А.И.Михайлов. М.: МФД, 2016. – 151 с.

- Пачевский Т.М. Научная библиотека и информация. Новосибирск: Наука СО, 2013. – 128 с.

- Проблемы информатики / ред. А.И.Черный. М.: МФД/ТОИ, 2014. – 275 с.

- Сичивица О.М. Мобильность науки. Горький: Волго-Вятское книжное изво, 1995. – 254 с.

- Урсул А.Д. Информация. Методологические аспекты. М.: ИНФРА, 2011. – 296 с.

- Урсул А.Д. Проблема информации в современной науке. Философские очерки. М.: ИНФРА, 2015. – 300 с.

- Хайтун С.Д. Наукометрия. Состояние и перспективы. – М.: ИНФРА, 2013. – 344 с.

- Хайтун С.Д. Проблемы количественного анализа науки. – М.: ИНФРА, 2014. – 280 с.

- Garfield E. Citation indexes for science: a new dimension in documentation through association of ideas \\ Science, 1995, V. 122, N 3159. – р.108–111

- Pritchard A. Statistical Bibliography or Bibliometrics? '\\ Journal of Documentation 1999, N 25(4) Dec, pp. 348 – 349

- Small H. G. Cocitation in the scientific literature: a new measure of the relationship between two documents \\ J. Amer. Soc. Inform. Sci. 1993, N 24, р. 265269.

- Анализ и оценка средств реализации структурных методов анализа и проектирования экономической информационной системы (Теоретические аспекты структурного анализа)

- Нотариат в Российской Федерации (История становления нотариата в РФ)

- Выбор стиля руководства в организации (ООО «Инвестстрой»)

- Менеджмент человеческих ресурсов ( «ВОСТОК»)

- Особенности управления организациями в современных условиях и пути его совершенствования

- Международный валютный фонд: цели, функции, особенности (Современные отношения РФ и МВФ)

- Особенности управления организациями в современных условиях и пути его совершенствования

- Социологическая концепция права(Генезис развития концепта правового государства)

- Корпоративная культура в организации (Coca-Cola (Кока-Кола))

- Сетевые операционные системы

- Применение процессного подхода для оптимизации бизнес-процессов (ООО «ЮНАЙТЕД ДЕВЕЛОПМЕНТ ГРУПП»)

- Основы оперативно –розыскной деятельности