Подходы к оценке количества информации

Содержание:

Введение

Информация - это отражение внешнего мира с помощью знаков или сигналов. Информационная ценность сообщения заключается в новых сведениях, которые в нем содержатся (в уменьшении незнания). С позиции материалистической философии информация есть отражение реального мира с помощью сведений (сообщений). В широком смысле информация - это общенаучное понятие, включающее в себя обмен сведениями между людьми, обмен сигналами между живой и неживой природой, людьми и устройствами.

Понимая информацию как один из основных стратегических ресурсов, без которого невозможна деловая, управленческая, вообще любая социально значимая деятельность, необходимо уметь оценивать ее как с качественной, так и с количественной стороны. На этом пути существуют большие проблемы из-за нематериальной природы этого ресурса и субъективности восприятия конкретной информации различными индивидуумами человеческого общества. С этой точки зрения классификация информации является важнейшим средством создания систем хранения и поиска информации, без которых сегодня невозможно эффективное функционирование информационного обеспечения управления.

Целью работы является рассмотрение видов информации, областей применения и подходов к ее количественной оценке. Для этого нужно рассмотреть следующие задачи и вопросы. Первой задачей является изучение общих понятий по данной теме. Рассмотрение конкретных способов оценки количества информации – вторая задача.

Термин "информация" происходит от латинского слова "informatio", что означает сведения, разъяснения, изложение. Несмотря на широкое распространение этого термина, понятие информации является одним из самых дискуссионных в науке. В настоящее время наука пытается найти общие свойства и закономерности, присущие многогранному понятию информация, но пока это понятие во многом остается интуитивным и получает различные смысловые наполнения в различных отраслях человеческой деятельности:

· в обиходе информацией называют любые данные или сведения, которые кого-либо интересуют. Например, сообщение о каких-либо событиях, о чьей-либо деятельности и т.п. "Информировать" в этом смысле означает "сообщить нечто, неизвестное раньше";

· в технике под информацией понимают сообщения, передаваемые в форме знаков или сигналов;

· в кибернетике под информацией понимает ту часть знаний, которая используется для ориентирования, активного действия, управления, т.е. в целях сохранения, совершенствования, развития системы (Н. Винер).

Клод Шеннон, американский учёный, заложивший основы теории информации — науки, изучающей процессы, связанные с передачей, приёмом, преобразованием и хранением информации, — рассматривает информацию как снятую неопределенность наших знаний о чем-то.

Применительно к информации как к объекту классификации выделенные классы называют информационными объектами. С этой точки зрения классификация информации является важнейшим средством создания систем хранения и поиска информации, без которых сегодня невозможно эффективное функционирование информационного обеспечения управления. Классификация носит всеобщий характер вследствие той роли, которую она играет как инструмент научного познания, прогнозирования и управления. Одновременно классификация выполняет функцию объективного отражения и фиксации результатов этого познания. при этом характер классификационной схемы, состав признаков классификации и глубина классификации определяется теми практическими целями, для реализации которых используется классификация, типом объектов классификации, а также условиями, в которых классификация будет использоваться.

1.2 Виды информации

Основные виды информации по ее форме представления, способам ее кодирования и хранения, что имеет наибольшее значение для информатики, это:

1. Графическая или изобразительная — первый вид, для которого был реализован способ хранения информации об окружающем мире в виде наскальных рисунков, а позднее в виде картин, фотографий, схем, чертежей на бумаге, холсте, мраморе и др. материалах, изображающих картины реального мира;

2. Звуковая — мир вокруг нас полон звуков и задача их хранения и тиражирования была решена с изобретение звукозаписывающих устройств в 1877 г. ее разновидностью является музыкальная информация — для этого вида был изобретен способ кодирования с использованием специальных символов, что делает возможным хранение ее аналогично графической информации;

3. Текстовая — способ кодирования речи человека специальными символами — буквами, причем разные народы имеют разные языки и используют различные наборы букв для отображения речи; особенно большое значение этот способ приобрел после изобретения бумаги и книгопечатания;

4. Числовая — количественная мера объектов и их свойств в окружающем мире; особенно большое значение приобрела с развитием торговли, экономики и денежного обмена; аналогично текстовой информации для ее отображения используется метод кодирования специальными символами — цифрами, причем системы кодирования (счисления) могут быть разными;

5. Видеоинформация — способ сохранения «живых» картин окружающего мира, появившийся с изобретением кино.

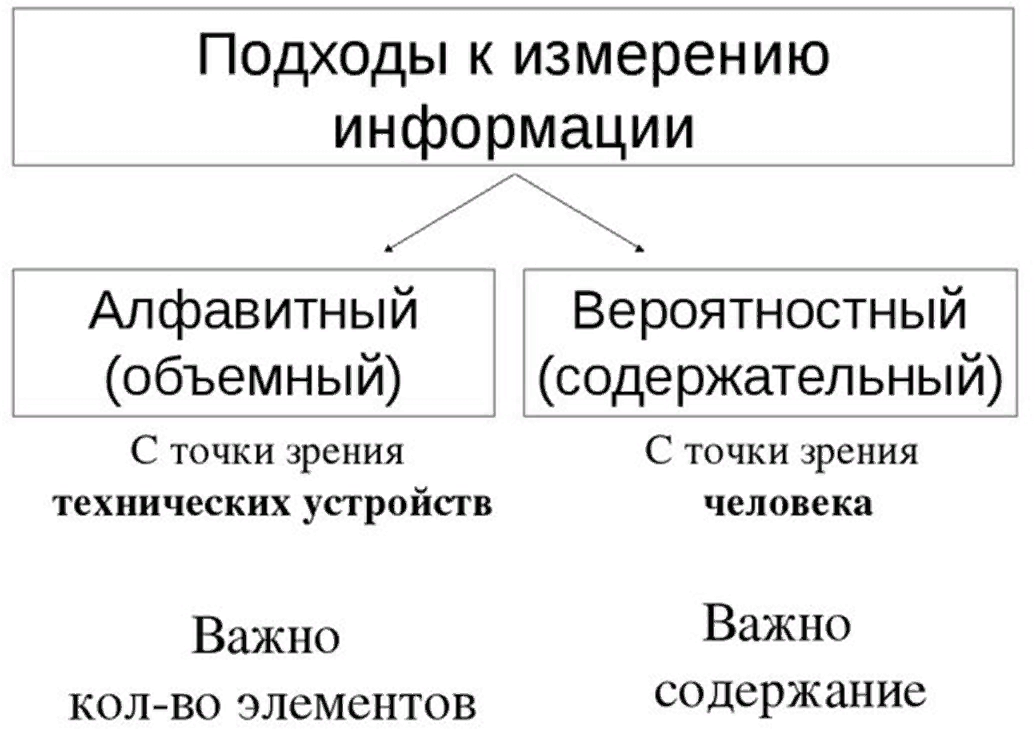

1.3 Виды подходов к оценке количества информации

(РИСУНОК 1)

(РИСУНОК 1)

При всем многообразии подходов к определению понятия информации, с позиции измерения информации нас будут интересовать два из них: определение К. Шеннона, применяемое в математической теории информации (содержательный подход), и определение А. Н. Колмогорова, применяемое в отраслях информатики, связанных с использованием компьютеров (алфавитный подход). (рисунок 1)

1.4 Содержательный подход

Содержательный подход к измерению информации.

Для человека информация — это знания человека. Рассмотрим вопрос с этой точки зрения.

Получение новой информации приводит к расширению знаний. Если некоторое сообщение приводит к уменьшению неопределенности нашего знания, то можно говорить, что такое сообщение содержит информацию.

Отсюда следует вывод, что сообщение информативно (т.е. содержит ненулевую информацию), если оно пополняет знания человека.

Но для того чтобы сообщение было информативно оно должно еще быть понятно. Быть понятным, значит быть логически связанным с предыдущими знаниями человека.

Получение всяких знаний должно идти от простого к сложному. И тогда каждое новое сообщение будет в то же время понятным, а значит, будет нести информацию для человека.

Сообщение несет информацию для человека, если содержащиеся в нем сведения являются для него новыми и понятными.

Очевидно, различать лишь две ситуации: «нет информации» — «есть информация» для измерения информации недостаточно. Нужна единица измерения, тогда мы сможем определять, в каком сообщении информации больше, в каком — меньше.

Единица измерения информации была определена в науке, которая называется теорией информации. Эта единица носит название «бит». Ее определение звучит так: сообщение, уменьшающее неопределенность знаний в два раза, несет 1 бит информации.

Проще всего определить объем информации в том случае, когда все результаты события могут быть реализованы с равной вероятностью. В этом случае формула Хартли используется для расчета информации.

Формула Хартли была предложена в 1928 году американским инженером Р.Хартли. Она связывает количество равновероятных состояний N с количеством информации I в сообщении о том, что любое из этих состояний реализовалось. Наиболее простая форма для данной формулы записывается следующим образом: 2I = N

Причем обычно значение N известно, а I приходится подбирать, что не совсем удобно. Поэтому те, кто знает математику получше, предпочитают преобразовать данную формулу так, чтобы сразу выразить искомую величину I в явном виде: I = log2 N

В более сложной ситуации, когда исход события ожидается с различной степенью достоверности, требуются более сложные вычисления с использованием формулы Шеннона.

Формула Шеннона: I = - ( p1log2 p1 + p2 log2 p2 + . . . + pN log2 pN),

где pi — вероятность того, что именно i-е сообщение выделено в наборе из N сообщений.

Легко заметить, что если вероятности p1, ..., pN равны, то каждая из них равна 1 / N, и формула Шеннона превращается в формулу Хартли.

1.5 Алфавитный подход

Алфавитный подход используется для измерения количества информации в тексте, представленном в виде последовательности символов некоторого алфавита. Такой подход не связан с содержанием текста. Количество информации в этом случае называется информационным объемом текста, который пропорционален размеру текста — количеству символов, составляющих текст. Иногда данный подход к измерению информации называют объемным подходом.

Каждый символ текста несет определенное количество информации. Его называют информационным весом символа. Поэтому информационный объем текста равен сумме информационных весов всех символов, составляющих текст.

Если допустить, что все символы алфавита встречаются в тексте с одинаковой частотой (равновероятно), то количество информации, которое несет каждый символ, вычисляется по формуле Хартли:

Алфавит - множество используемых символов в языке.

Мощность алфавита (N) - количество символов, используемых в алфавите.

i=log2N , где N - мощность алфавита.

Формула Хартли задает связь между количеством возможных событий N и количеством информации i :

N=2i

Заключение

Между вероятностным и объемным количеством информации соотношение неоднозначное. Далеко не всякий текст, записанный двоичными символами, допускает измерение объема информации в вероятностном (кибернетическом) смысле, но заведомо допускает его в объемном. Далее, если некоторое сообщение допускают измеримость количества информации в обоих смыслах, то это количество не обязательно совпадает, при этом кибернетическое количество информации не может быть больше объемного. В прикладной информатике практически всегда количество информации понимается в объемном смысле. Как ни важно измерение информации, нельзя сводить к нему все связанные с этим понятием проблемы. При анализе информации социального происхождения на первый план могут выступить такие ее свойства как истинность, своевременность, ценность, полнота и т.д. Их невозможно оценить в терминах «уменьшение неопределенности» (вероятностный подход) или числа символов (объемный подход). Обращение к качественной стороне информации породило иные подходы к ее оценке.

Литература

- Иванов А. М . статья «Измерение информации .Алфавитный подход» .

( https://иванов-ам.рф/informatika_kabinet/inf_prozes/inf_prozes_05.html )

- Гераскина Л.Г лекция «Подходы к понятию информации и измерению информации.»

(https://infourok.ru/lekciya-podhodi-k-ponyatiyu-informacii-i-izmerinformacii- 3517892.html )

- Книга Информатика Семакин И.Г., Хеннер Е.К., Шеина Т.Ю. Базовый уровень , 2015 год , стр 21-26, §3-4

(https://znayka.pw/uchebniki/10-klass/informatika-10-klass-semakin-i-g-henner- e-k-sheina-t-yu-bazovyj-uroven/ )

- Л. Л. Босова, А. Ю. Босова. Информатика. Базовый уровень: учебник для 10 класса — М.: БИНОМ., 2017, стр 16 , §2

(https://znayka.pw/uchebniki/10-klass/informatika-10-klass-bazovyj-uroven-bosova-l-l-uchebnik/ )

- «Черная смерть» в Европе 16 века

- Планета Фаэтон

- Понятие и классификация инвестиционных проектов

- Спекуляция и её роль в экономике (Понятие и сущность спекуляции)

- Элементы делового этикета: визитки

- Портфель ценных бумаг, их классификаций

- Организационные структуры управления проектами

- Искусство ведения переговоров (Ведение деловых переговоров. Техника, общая характеристика, основные этапы.)

- Управление персоналом кризисного предприятия (Управление персоналом кризисного предприятия)

- Развитие систем электронного документооборота.

- История менеджмента как науки

- Обеспечение конфиденциальности документов и разграничения прав доступа в системе электронного документооборота